- •Раздел № 3 Методы оптимизации технических объектов

- •Виды описания проектируемых объектов и классификация их параметров

- •Поисковая оптимизация

- •Выбрать начальную точку поиска.

- •Аддитивный критерий

- •2) Не учитывает конкретных требований тз в коэффициентах влияния. Max f(X).

- •Максиминные (минимаксные) критерии.

- •5) Статистический критерий

- •Классификация поисковых методов оптимизации

- •Метод покоординатного спуска или Метод Гаусса – Зейделя

- •Методы одномерного поиска

- •Методы оптимизации в случае овражных или гребневых целевых функций

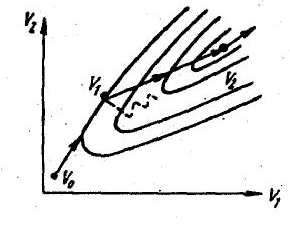

Метод покоординатного спуска или Метод Гаусса – Зейделя

min F(X);

X0€XП

Минимум целевой функции в области протяжения.

Х0 – начальная точка поиска.

В

методе Гаусса – Зейделя поиск совершают

в направлении координатных осей.

hнач – начальная величина шага поиска.

Для поиска минимума используются методы одномерной оптимизации.

Метод случайного поиска

Направление поиска выбирается случайно, путём выбора n случайных чисел, равномерно распределённых на отрезке [-1;1) из генератора случайных чисел, который есть в каждой ЭВМ.

n – число управляемых параметров.

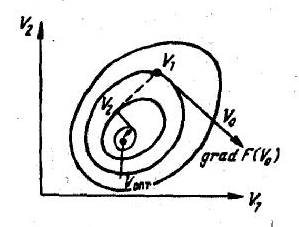

Метод градиента

grad F(X) = (∂F/∂x1; ∂F/∂x2; …; ∂F/∂xn)

F(x1; x2)

Производные вычисляются численно, путём приращения управляемых параметров.

x1 = x1,0 + ∆x1

∂F/ ∂x1 = ∆F/∆x1 ; ∆F = F(x10 + ∆x1) – F(x10)

В каждой точке для нахождения производных необходимо n+1 вычислений F(X).

Метод наискорейшего спуска

Метод Ньютона

В основу метода положен одноимённый метод решения нелинейных алгебраических уравнений.

grad F(X) = 0;

Обозначим Ф(X) = ∂F(x)/∂x = 0

Применим к данной системе уравнений метод Ньютона.

Ф(Xk) + ∂F(Xk)/∂X ∆X ≈0,

где ∆Х – значение Xk+1 - Xk

Xk+1 = Xk – (∂Ф/∂X)-1 * Ф(Xk)

X

k+1

=

Xk

– Юk-1

grad

F(Xk)

- Формула

Ньютона.

k+1

=

Xk

– Юk-1

grad

F(Xk)

- Формула

Ньютона.

Если целевая функция является квадратичным многочленом по управляемым параметрам, то минимум находится за один шаг.

Недостатки метода:

Высокая трудоёмкость вычисления и обращения матрицы Гессе.

Не всегда имеет место сходимость решения.

Методы одномерного поиска

Найти минимум целевой функции: min F(Xk + hg) = min f(h)

h>0

g – единичный вектор выбранного направления.

Метод половинного деления (бисекции)

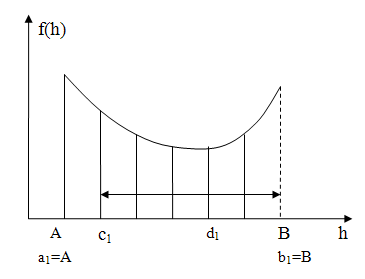

Метод золотого сечения

Золотое

сечение

– это деление отрезка АВ

на 2 части таким образом, что большая

его часть АС

является

средней пропорциональной между отрезком

АВ

и его меньшей частью СВ.

АВ/АС

= АС/СВ

Для шага ак и вк

cк = ак + 0,382lk

dk = вк – 0,382 lk

lk = bk - ak

Если f(ck) < f(dk), то bk+1 = dk; dk+1 = ck; ak+1 = ak;

Если f(ck) ≥ f(dk), то ak+1 = ck; ck+1 = dk; bk+1 = bk

Если lk ≤ ε – условие окончания операции.

В методе золотого сечения для сужения интервала неопределённости необходимо сделать только одно вычисление.

Метод чисел Фибоначчи

βk = βk-1 + βk-2 , где β2 = β1 , βk = 1,1,2,3,5,8,13,21,34,55,89…

k = 0,1,2,3,4,5, 6, 7, 8, 9, 10,…

ε ≈ В-А / 1,618N ,

где N – число итераций (число последовательных вычислений). N задаётся.

Определяется порядковый номер числа Фибоначчи К = N + 2

Это – максимальный номер числа Фибоначчи- К.

сn = an +αnln ; αn = βN+2-n / βN+3-n ;

dn = bn- αnln.

Метод полиноминальной аппроксимации

f (h)

= a0

+ a1h

+ a2h2

h` = a1/2a2

(h)

= a0

+ a1h

+ a2h2

h` = a1/2a2

h` = hc + (h[f(ha) – f(hb)]) / (2[f(ha) – 2f(hc) + f(hb)])

ha = hc – H1

hb = hc + H1

Сведение задач условной оптимизации к безусловной

Для сведения задач условной оптимизации к безусловной используют метод штрафных функций.

Метод внешней точки

Например, имеем ограничения типа неравенств φ(X) < 0

Ф(Х) = F(X) + Qk(X)

Qk(X) = rk ∑ [max {0; φi(X)}] 2; rk > 0 – функция штрафа в методе внешней точки.

Решаем задачу. Найти минимум целевой функции при выполнении ограничений - min F(X)

ХД = {X| φ(X) < 0}

Ищем минимум новой функции

min Ф(Х)

Поиск начинают с небольших значений rk, постепенно его увеличивая до тех пор, пока разница между предыдущим и последующим значением не станет меньше заданной погрешности δ.

ΔХ = Хk+1 – Хk < δ.

Метод барьерных функций или метод внутренней точки

Ф(Х) = F(X) – rk ∑ 1/φi(X)

Где функция штрафа имеет вид: Qk(X) = -rk ∑ 1/φi(X)