- •1. Знания как основа принятия решений

- •2. Понятие «система»

- •4. Формализованные знания. Сущность и сферы использования. Примеры.

- •5. Неформализованные знания и задачи

- •6. Слабоструктурированные задачи. Источники неопределенности при принятии решений.

- •7. Основные виды неопределенности и способы ее уменьшения

- •8. Понятие «искусственный интеллект». Задачи ии. Основные этапы развития ии

- •9. Особенности человеческого мышления. Принципы построения систем ии

- •10. Особенности и признаки интеллектуальных информационных систем.

- •11. Двойственная природа знаний, используемых в интеллектуальных системах

- •12. Понятие «экспертная система». Основные модели представления знаний в экспертных системах.

- •13. Логические модели представления знаний. Модель, основанная на логике высказываний

- •14. Логические модели представления знаний. Модель, использующая исчисление предикатов (э-существует y-любой!!!!!!)

- •15. Продукционная модель представления знаний. Структура экспертных систем продукционного типа.

- •16) Механизм логического вывода в продукционных системах. Примеры логического вывода

- •17 Управляющий компонент продукционной экспертной системы

- •27. Способы дефазификации результатов нечеткого вывода.

- •18. Общая хар-ка матем-го аппарата теории нечетких множеств.

- •19. Основные идеи теории нечетких множеств. Сравнение обычных и нечетких множеств.

- •21. Алгебраические операции над нечеткими множествами.

- •20. Операции над нечеткими множествами (кроме алгебраических).

- •22. Нечеткая и лингвистическая переменные.

- •23. Нечеткие отношения.

- •24. Операции композиции нечетких отношений и нечеткой импликации, их значение для нечеткого логического вывода.

- •26. Особенности нечеткого логического вывода по Мамдани и Ларсену

- •28. Нечеткие аппроксиматоры.

- •29. Основные проблемы, решаемые при помощи искусственных нейронных сетей.

- •30. Биологический нейрон.

- •Биологический нейрон 2

- •31. Понятие коннекционизма

- •32 Схема формального нейрона

- •33. Функции активации формального нейрона, их смысл и основные виды

- •34. Сравнение ветвей компьютерной эволюции.

- •35 Архитектуры нейронных сетей

- •36. Обучение нейросетей.

- •Цель обучения

- •37. Обучение нейронных сетей как задача оптимизации

- •38. Сравнение ветвей компьютерной эволюции.

- •39. Генетические алгоритмы. Основные понятия, принципы и особенности построения.

- •40. Обучение нейронных сетей методом статистических испытаний.

- •Знания как основа принятия решений

- •Понятие «система»

40. Обучение нейронных сетей методом статистических испытаний.

Нейронная сеть представляет собой совокупность нейронов, связанных между собой соответствующим образом.

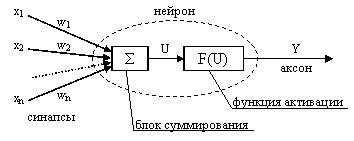

Нейрон – преобразовательный элемент, имеющий некоторое количество входов (синапсов), на которые поступают входные сигналы хi и один выход (аксон), с которого снимается выходной сигнал у. Каждый синапс имеет вес wi, на который умножается входной сигнал xi.

Структура нейрона:

В

![]() и блок функции активации Y

= F(U).

и блок функции активации Y

= F(U).

Таким образом, нейрон функционирует за два такта:

1) суммирование входных сигналов;

2) вычисление Y по функции активации.

Нейронные сети относятся к классу аппроксиматоров и «черных ящиков», аппроксимирующих некоторые функции вида Y = F(X), где Y – вектор выходных переменных, Х – вектор входных.

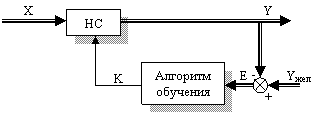

Процесс аппроксимации заключается в подборе весовых коэффициентов wij и называется обучением НС. То есть НС может функционировать в двух режимах:

эксплуатации, когда на вход подаются сигналы, а на выходе снимаются результаты вычислений;

обучения, когда происходит корректировка весов таким образом, чтобы выходные сигналы наиболее точно соответствовали желаемым.

От качества обучения НС зависит точность ее работы в режиме эксплуатации.

Структура процесса обучения представлена на рисунке, где обозначены:

Yжел – желаемые значения выходных сигналов,

Е – ошибка обучения (Е = Yжел – Y),

К

– корректирующие воздействия (обычно

изменения весов

![]() wij).

wij).

Для обучения НС составляется обучающая выборка входных сигналов и соответствующих им выходных. Выборка может быть разделена на две части: рабочую выборку (на основе которой производится собственно обучение) и тестирующую выборку (для проверки качества обучения).

Далее определяется структура НС.

Существует несколько методов обучения, которые можно классифицировать по способам использования учителя:

обучение с учителем (коррекция весов производится исходя из сравнения текущего и желаемого выходных векторов);

обучение с последовательным подкреплением знаний (сети не даются желаемые значения выходов, а ставится оценка «хорошо» или «плохо»);

обучение без учителя (сеть сама вырабатывает правила обучения путем выделения особенностей из набора входных данных). По использованию элементов случайности методы обучения подразделяются:

- на детерминистские (коррекция на основе анализа входных и выходных сигналов, а также дополнительной информации, например, желаемых выходов);

- на стохастические (случайное изменение весов в ходе обучения – Больцмановское обучение).

Метод статистических испытаний применяется для моделирования сложных систем, в которых не возможно или не целесообразно получить аналитические модели, описывающие протекающие процессы. Данный метод также используется в случаях, когда реальные испытания системы оказываются дорогостоящими или их не возможно проводить по причинам социального, военного и других смыслов. Например, необходимо определить вероятность попадания ракеты в цель. Для этого необходимо произвести 1000 пусков – это дорого. Поэтому строят математический аналог системы, проводят испытания и обрабатывают полученные результаты. Суть метода заключается в замене эксперимента с реальной системой, экспериментом с ее математическим аналогом и имитацией работы системы (имитационное моделирование). Метод статистических испытаний основан на законах больших чисел, а именно на двух предельных теоремах Чебышева и Бернулли.

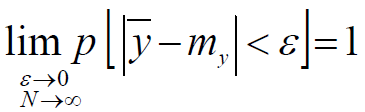

Теорема

Чебышева:

при неограниченном проведении опытов

среднее арифметическое y

по

вероятности стремится к математическому

ожиданию my

:

где

ε

> 0.

где

ε

> 0.

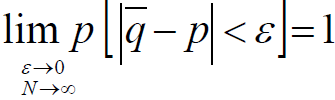

Теорема Бернулли: при неограниченном увеличении опытов частота

события

q

сходится

по вероятности к его вероятности p:

где

ε

> 0.

где

ε

> 0.

Теорема Бернулли позволяет определить вероятность совершения некоторого события.

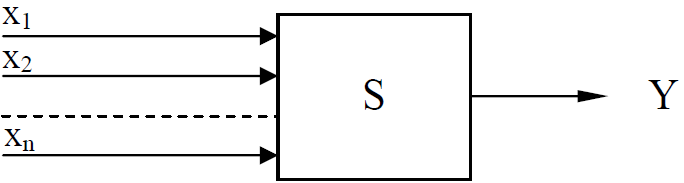

Испытания

проводятся следующим образом. Известна

некоторая система S (черный ящик). Система

S имеет множество входов X

(случайные

величины)

и

один выход Y:Ч

Таким образом, моделирование содержит три этапа:1 Разработка и ввод в ЭВМ моделирующего алгоритма.2 Генерирование входных случайных величин с заданными функциями и параметрами распределения и многократное повторение опытов.3 Статистическая обработка результатов моделирования.