- •1. Основні засади системного аналізу

- •2. Поняття системи, її властивості та структура

- •Пов'язані зі структурою

- •Пов'язані з ресурсами та особливостями взаємодії із середовищем

- •3. Взаємодія систем із зовнішнім середовищем

- •4. Класифікація систем

- •5.Особливості, структура та функціонування ек. Систем.

- •6.Особливості, структура та функціонування виробничих(вир.) систем.

- •7.Особливості фінансових систем

- •8. Декомпозиція у моделюванні та системному аналізі.

- •9. Декомпозиція односекторної моделі економіки

- •10. Агрегування в моделях міжгалузевих зв’язків

- •11.Проблема невизначеності та випадковості

- •12.Інформаційні аспекти дослідження систем. Інформація та її передавання

- •13. Поняття управління. Управління і система

- •14. Типи (способи) управління системами

- •15.Прості системи управління

- •16.Системи управління з адаптацією

- •17.Модельні системи управління

- •18.Семіотичні системи управління

- •Етапи управління

- •20.Особливості управління у виробничих системах

- •21. Базова модель прийняття рішень та її структура

- •22. Головні завдання системного аналізу та його основні етапи.

- •Процес виконання системного аналізу

- •23. Формулювання проблеми у системному дослідженні

- •24. Визначення цілей і формування критеріїв у системному дослідженні

- •Генерування альтернатив у системному дослідженні

- •26.Алгоритмізація системних досліджень.

- •27.Проблеми реалізації системних досліджень

- •28.Способи вирішення проблеми та етика системних досліджень

- •29. Поняття моделі та суть методу моделювання.

- •30. Класифікація моделей.

- •31. Головні етапи моделювання економічних процесів

- •32. Моделі типу “життєвий цикл”

- •33. Модель чорної скриньки.

- •34.Статичні і динамічні моделі систем.

- •35. Математичний опис динамічних систем

- •36. Модель національної економіки

- •Статичні матричні макроекономічні моделі

- •Моделі виробничих систем

- •39.Основні характеристики виробничих функцій. Випадок функції Кобба-Дугласа

- •40.Функції виробничих затрат

- •41.Сіткові моделі

- •42.Проблема класифікації методів системного аналізу

- •43.Метод колективної генерації ідей або "мізкової атаки"

- •44.Метод сценаріїв

- •45.Методи експертних оцінок

- •46. Метод Дельфі

- •47. Метод дерева цілей.

- •48. Морфологічні методи (або метод Цвіккі)

- •49. Особливості застосування кількісних методів у системному дослідженні

- •51. Застосування математичного програмування у системному аналізі

- •52. Застосування лінійного та нелінійного програмування у системному аналізі

- •53.Застосування блокового програмування у системному аналізі

- •54.Застосування дискретного програмування у системному аналізі

- •55.Застосування динамічного програмування у системному аналізі

- •56.Статистичні методи у дослідженні систем.

- •57.Теорія масового обслуговування

- •58.Теорія ігор.

- •59.Машинне імітування.

- •60. Графи та їхнє застосування.

12.Інформаційні аспекти дослідження систем. Інформація та її передавання

Зв’язки між елементами системи виконують різні функції. Через них може передаватися енергія, речовина. З погляду кібернетики та загальної теорії систем, важливу роль відіграє інформаційний зміст зв’язків, тобто використання зв’язків з метою передавання відомостей щодо різних станів елементів системи.

Поняття інформації є одним з головних у кібернетиці та теорії систем. Слово інформація походить від латинського informatio – роз’яснення, виклад. Під інформацією зазвичай розуміють будь-які відомості та дані про об’єкти, системи, явища, процеси, ситуації. Якщо стан одного об’єкта перебуває у певній відповідності зі станом іншого об’єкта, то перший містить інформацію щодо другого і є носієм інформації про нього.Матеріальний носій інформації, що є засобом перенесення інформації у просторі та часі, називають сигналом.

Слово сигнал походить від латинського signum, що означає знак. Вид сигналів не залежить від змісту інформації, він є результатом угоди між особами, що передають та сприймають інформацію. Тому сигнали можуть легко перетворюватись з одного виду в інший, не змінюючи змісту інформації, а також зберігатися (наприклад, у формі літерного або магнітного запису) з метою використання у майбутньому.

Зв’язки, які слугують для передавання інформації у системах або між системами, називають каналами зв’язку або комунікаціями.

Американський інженер і математик Клод Шеннон пов’язав кількість інформації з поняттям інформаційної ентропії, яка характеризує невизначеність однієї випадкової величини за відомих значень іншої. Кількість інформації виявилась мірою зняття невизначеності випадкової величини через спостереження іншої випадкової величини. Пояснимо це докладніше.

Нехай

X - дискретна випадкова величина, що

набуває скінченну кількість значень

,

,

(множина натуральних чисел) з ймовірностями

(множина натуральних чисел) з ймовірностями

,

а Y – дискретна випадкова величина, що

набуває значень

,

а Y – дискретна випадкова величина, що

набуває значень

з

ймовірностями

з

ймовірностями

,

де

,

де

Тоді кількість інформації I(X,Y) щодо

величини Y, що міститься в X, визначають

за формулою:

Тоді кількість інформації I(X,Y) щодо

величини Y, що міститься в X, визначають

за формулою:

(2.10)

(2.10)

де

– ймовірність перерізу подій

– ймовірність перерізу подій

і

і

.

.

Головні властивості кількості інформації такі:

1)

тоді і лише тоді, коли випадкові величини

є незалежними, тобто

<

тоді і лише тоді, коли випадкові величини

є незалежними, тобто

< за усіх значень i та k;

за усіх значень i та k;

2)

завжди

і рівність є можливою тоді, коли Y є

функцією від X (наприклад,

і рівність є можливою тоді, коли Y є

функцією від X (наприклад,

);

);

3) .

.

Іншим головним поняттям теорії інформації є ентропія випадкової величини, яка для дискретної величини набуває вигляду:

(2.11)

(2.11)

Кількість інформації та ентропія зв’язані співвідношенням:

.(2.12)

.(2.12)

Одиницею вимірювання кількості інформації та ентропії є біт (або двійкова одиниця). Ентропію в один біт має джерело інформації (випадкова величина) з двома рівноймовірними повідомленнями (з двома рівноймовірними значеннями).

Величина ентропії вказує на середню кількість двійкових знаків (наприклад, 0 і 1), необхідну для запису можливих значень випадкової величини. Якщо величини X та Y незалежні, то для запису значень X потрібно H(X) двійкових знаків, для запису Y –H(Y) знаків, а для пари (X,Y) – H(X)+H(Y) знаків. Якщо X та Y– залежні, то для запису пари (X,Y) необхідна менша кількість знаків через рівність (2.12).

Коли X та Y – неперервні випадкові величини, які мають спільну щільність розподілу P(X,Y) та щільність розподілів p(x) і p(y) відповідно, граничним переходом з формул (2.10)-(2.12) можна отримати формули для визначення кількості інформації I(X,Y) та диференційної ентропії h(x) вигляду

;

;

;

;

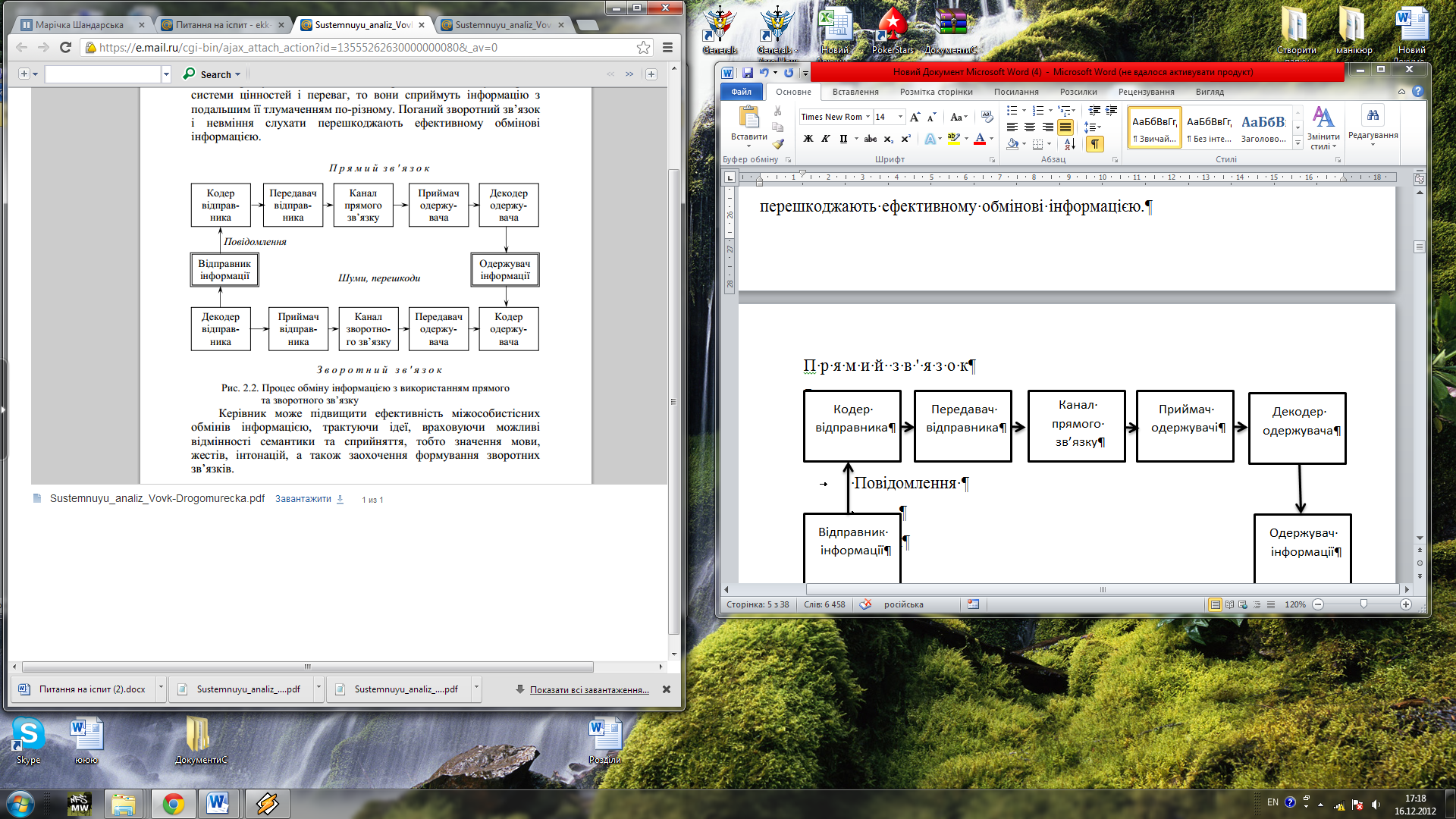

Канал зв’язку відзначається швидкістю передачі інформації, тобто кількістю інформації, яку передають за одиницю часу, та пропускною здатністю каналу, що є межею швидкості передачі інформації у цьому каналі. На рис.2.2 зображено загальний процес обміну інформацією з використанням прямої та зворотної лінії зв’язку.

Зворотний зв’язок є реакцією одержувача інформації, що вказує на те, чи є зрозумілою передана інформація, тобто допомагає подолати шум (перешкоди). Шум – це те, що спотворює, викривлює інформацію у лінії зв’язку через фізичні взаємодії сигналу та середовища.

В організаційних системах важливу роль, крім технічних каналів зв’язку, відіграють особисті комунікації, які мають особливості, спричинені людською психологією та фізіологією. Шуми в інформаційній системі можуть виникати внаслідок мовленнєвих відмінностей та відмінностей у сприйнятті. Люди зазвичай реагують тільки на те, що сприймають. Якщо у них різні системи цінностей і переваг, то вони сприймуть інформацію з подальшим її тлумаченням по-різному. Поганий зворотний зв’язок і невміння слухати перешкоджають ефективному обмінові інформацією.

Рис. 2.2. Процес обміну інформацією з використанням прямого

та зворотного зв’язку

Керівник може підвищити ефективність міжособистісних обмінів інформацією, трактуючи ідеї, враховуючи можливі відмінності семантики та сприйняття, тобто значення мови, жестів, інтонацій, а також заохочення формування зворотних зв’язків.