- •Семенов ю.А. (гнц итэф) Общие принципы построения сетей Оглавление

- •Распределения визитов сайта book.Itep.Ru по регионам за месяц (данные Rambler)

- •1 Введение (общие принципы построения сетей) Семенов ю.А. (гнц итэф)

- •2 Преобразование, кодировка и передача информации Семенов ю.А. (гнц итэф)

- •2.1 Передача сигналов по линиям связи Семенов ю.А. (гнц итэф)

- •2.2 Представление электрических сигналов в цифровой форме Семенов ю.А. (гнц итэф)

- •2.3 Цифровые каналы t1 и е1 Семенов ю.А. (гнц итэф)

- •2.4 Методы преобразования и передачи звуковых сигналов Семенов ю.А. (гнц итэф)

- •2.4.1 Дельта-модуляция Семенов ю.А. (гнц итэф)

- •2.4.2 Кодировщики голоса (Vocoder) Семенов ю.А. (гнц итэф)

- •2.4.3 Передача голоса по каналам Интернет Семенов ю.А. (гнц итэф)

- •2.5 Методы преобразования и передачи изображения Семенов ю.А. (гнц итэф)

- •Стандарт mpeg-1 и -2

- •Часть 1 mpeg-2 относится к объединению одного или более элементарных аудио или видео потоков, а также прочих данных в один или несколько потоков, удобных для записи или передачи.

- •Интерактивное телевидение

- •2.5.1 Стандарт mpeg-4 Семенов ю.А. (гнц итэф)

- •1. Особенности стандарта mpeg-4

- •1.1. Кодированное представление медийных объектов

- •1.2. Состав медийных объектов

- •1.3. Описание и синхронизация потоков данных для медийных объектов

- •1.4. Доставка потоков данных

- •1.5. Взаимодействие с медийными объектами

- •1.6. Менеджмент и идентификация интеллектуальной собственности

- •2. Основные функции в mpeg-4 версия 1

- •2.2. Системы

- •2.3. Аудио-система

- •2.4. Видео-система

- •2.4.1. Поддерживаемые форматы

- •2.4.2. Эффективность сжатия

- •2.4.3. Функции, зависящие от содержимого (Content-Based)

- •2.4.4. Масштабируемость текстур изображений и видео

- •2.4.5. Кодирование формы и Alpha-представление

- •2.4.6. Надежность в средах, подверженных ошибкам

- •2.4.7. Анимация лица

- •3.2.2. Анимация тела

- •3.2.3. Кодирование 3-d полигональных сеток

- •3.3. Звук

- •4. Расширения mpeg-4 за пределы версии 2

- •4.1. Визуальная область системы

- •4.2. Системы

- •4.2.2. Текстуальный формат

- •4.2.3. Улучшенная модель синхронизации

- •5. Профайлы в mpeg-4

- •5.1. Визуальные профайлы

- •5.2. Аудио профайлы

- •5.3. Профайлы графики

- •5.4. Графические профайлы сцены

- •5.5. Профайлы mpeg-j

- •5.6. Профайл дескриптора объекта

- •6. Верификационное тестирование: проверка работы mpeg

- •6.1. Видео

- •6.1.1. Тесты эффективности кодирования 6.1.1.1. Низкие и средние скорости передачи бит (версия 1)

- •6.1.1.2. Кодирование, базирующееся на содержимом (версия 1)

- •6.1.1.3. Профайл продвинутой эффективности кодирования ace (Advanced Coding Efficiency) (версия 2)

- •6.1.2. Тесты устойчивости к ошибкам 6.1.2.1. Простой профайл (версия 1)

- •6.1.2.2. Простой продвинутый профайл реального времени arts (Advanced Real-Time Simple) (версия 2)

- •6.1.3. Тестирование стабильности временного разрешения 6.1.3.1. Простой продвинутый профайл реального времени arts (Advanced Real-Time Simple) (версия 2)

- •6.1.4. Проверки масштабируемости 6.1.4.1. Простой масштабируемый профайл (версия 1)

- •6.1.4.2. Центральный профайл (core profile версия 1)

- •6.2. Звук

- •7. Промышленный форум mpeg-4

- •8. Детальное техническое описание mpeg-4 dmif и систем

- •8.1.1. Вычислительная модель dmif

- •8.2. Демультиплексирование, синхронизация и описание потоков данных

- •8.2.1. Демультиплексирование

- •8.2.2. Синхронизация и описание элементарных потоков

- •8.2.3. Управление буфером

- •8.2.4. Идентификация времени

- •8.3. Улучшенная модель синхронизации (FlexTime)

- •8.3.1. Гибкая длительность

- •8.3.2. Относительное время начала и конца

- •8.3.3. Поддержка FlexTime в mpeg-4

- •8.3.3.1. Узел TemporalTransform

- •8.3.3.2. Узел TemporalGroup

- •8.3.3.3. Дескриптор сегмента (SegmentDescriptor)

- •8.3.4. Модель исполнения

- •8.4. Описание синтаксиса

- •8.5. Двоичный формат описания сцены bifs (Binary Format for Scene description)

- •8.5.1. Продвинутый формат bifs

- •8.6. Взаимодействие с пользователем

- •8.7. Ipr идентификация и защита

- •8.8. Информация содержимого объекта

- •8.9. Формат файлов mpeg-4

- •9. Детальное техническое описание визуальной секции mpeg-4

- •9.1. Приложения видео-стандарта mpeg-4

- •9.2. Натуральные текстуры, изображения и видео

- •9.3. Синтетические объекты

- •9.4. Масштабируемое кодирование видео-объектов

- •9.5. Устойчивость в среде, предрасположенной к ошибкам

- •9.6. Улучшенная стабильность временного разрешения с низкой задержкой буферизации

- •9.7. Кодирование текстур и статические изображения

- •9.8. Кодирование нескольких видов и большого числа вспомогательных компонентов

- •9.8.1. Анимация лица

- •9.8.2. Анимация тела

- •9.8.3. Анимируемые 2-d сетки

- •9.8.5. Масштабируемость, зависящая от изображения

- •9.9. Структура средств для представления натурального видео

- •9.10. Поддержка обычной функциональности и зависящей от содержимого

- •9.11. Видео изображение mpeg-4 и схема кодирования

- •9.11.1. Эффективность кодирования в V.2

- •9.12. Кодирование текстур в статических изображениях

- •9.13. Масштабируемое кодирование видео-объектов

- •9.14. Устойчивость в среде, предрасположенной к ошибкам

- •9.14.1. Ресинхронизация

- •9.14.2. Восстановление данных

- •9.14.3. Сокрытие ошибок

- •10. Подробное техническое описание mpeg-4 аудио

- •10.1. Натуральный звук

- •10.2. Улучшения mpeg-4 аудио V.2

- •10.2.1. Устойчивость к ошибкам

- •10.2.2. Аудио-кодирование с малыми задержками

- •10.2.3. Масштабируемость гранулярности

- •10.2.4. Параметрическое кодирование звука

- •10.2.5. Сжатие тишины celp

- •10.2.6. Устойчивое к ошибкам hvxc

- •10.2.7. Пространственные характеристики среды

- •10.2.8. Обратный канал

- •10.2.9. Транспортный поток звука

- •10.3. Синтетический звук

- •10.3.1. Синтез с множественным управлением (Score Driven Synthesis).

- •11. Приложение. Словарь и сокращения

- •2.5.2 Стандарт mpeg-7 Семенов ю.А. (гнц итэф)

- •1. Введение

- •1.1. Контекст mpeg-7

- •1.2. Цель mpeg-7

- •1.3. Область действия стандарта

- •1.4. Область применения mpeg-7

- •1.5. План и метод работы

- •1.6. Части mpeg-7

- •1.7. Структура документа

- •2. Главные функции mpeg-7 2.1. Системы mpeg-7

- •2.2. Язык описания определений mpeg-7

- •2.3. Аудио mpeg-7

- •2.4. Визуальный mpeg-7

- •2.5. Основные объекты и схемы описания мультимедиа mpeg-7

- •2.6. Эталонные программы mpeg-7: модель экспериментов (eXperimentation Model)

- •3. Детальное техническое описание стандарта mpeg-7 3.1. Системы mpeg-7

- •3.1.1. Архитектура терминала

- •3.1.2. Нормативные интерфейсы 3.1.2.1. Описание нормативных интерфейсов

- •3.1.2.2. Верификация стандарта

- •3.2. Язык описания определений mpeg-7 (ddl)

- •3.2.1. Разработка контекста

- •3.2.2. Обзор схемы xml

- •3.2.3. Схема xml: Структуры

- •3.2.4. Схема xml: Типы данных

- •3.2.5. Расширения схемы xml mpeg-7

- •3.3. Аудио mpeg-7

- •3.3.1. Описание системы аудио mpeg-7

- •3.3.2. Средства описания аудио верхнего уровня (d и ds)

- •3.3.2.1. Средства описания тембра музыкальных инструментов

- •3.3.2.2. Средства распознавания звука

- •3.3.2.3. Средства описания содержимого сказанного

- •3.3.2.4. Средства описания мелодии

- •3.4.1.3. Временные ряды

- •3.4.1.4. Пространственные координаты 2d

- •3.4.1.5. Временная интерполяция

- •3.4.2. Описатели цвета

- •3.4.2.1. Цветовое пространство

- •3.4.2.2. Оцифровка цвета

- •3.4.2.3. Доминантный цвет(а)

- •3.4.2.4. Масштабируемый цвет

- •3.4.2.5. Описатель структуры цвета

- •3.4.2.6. Выкладка цвета

- •3.4.2.7. Цвет GoF/GoP

- •3.4.3. Описатели текстуры

- •3.4.3.1. Описатели однородной текстуры

- •3.4.3.2. Просмотр текстуры

- •3.4.3.3. Краевая гистограмма

- •3.4.4. Описатели формы

- •3.4.4.1. Форма, базирующаяся на областях (Region-Based)

- •3.4.4.2. Форма, основанная на контуре

- •3.4.5. Дескрипторы перемещения

- •3.4.5.1. Движение камеры

- •3.4.5.2. Траектория движения

- •3.4.5.3. Параметрическое движение

- •3.4.5.4. Двигательная активность

- •3.4.6. Локализация 3.4.6.1. Локатор области

- •3.4.6.2. Пространственно-временной локатор

- •3.4.7. Прочие 3.4.7.1. Распознавание лица

- •3.5. Схемы описания мультимедиа mpeg-7

- •3.5.1. Средства организации mds

- •3.5.1.1. Базовые элементы

- •3.5.1.2. Управление содержимым

- •3.5.1.3. Описание содержимого

- •3.5.1.4. Навигация и доступ

- •3.5.1.5. Организация содержимого

- •3.5.1.6. Интеракция с пользователем

- •3.5.2. Управление содержимым

- •3.5.2.1. Средства описания среды

- •3.5.2.2. Создание и производство средств описания

- •3.5.2.3. Средства описания использования содержимого

- •3.5.3. Описание содержимого 3.5.3.1. Описание структурных аспектов содержимого

- •3.5.3.2. Описание концептуальных аспектов содержимого

- •3.5.4. Навигация и доступ

- •3.5.4.1. Резюме

- •3.5.4.2. Разделы и декомпозиции

- •3.5.4.3. Вариации содержимого

- •3.5.5. Организация содержимого

- •3.5.5.1. Собрания (Collections)

- •3.5.5.2. Модели

- •3.5.6. Взаимодействие с пользователями

- •3.6. Эталонные программы: экспериментальная модель

- •3.6.1. Цели

- •3.6.2. Извлечение и приложения клиента

- •3.6.3. Модульность xm-программ

- •3.6.4. Модули приложения 3.6.4.1. Медийные декодеры

- •3.6.4.2. Мультимедийные данные

- •3.6.4.3. Средства выборки

- •3.6.4.4. Класс дескрипторов

- •3.6.4.5. Схема кодирования

- •3.6.4.6. Средство поиска

- •3.6.5. Типы приложений в xm-программах 3.6.5.1. Извлечение из среды

- •3.6.5.2. Приложение поиска и извлечения

- •3.6.5.3. Приложение транскодирования среды

- •3.6.5.4. Приложение описания фильтрации

- •3.6.6. Модель ключевого приложения mpeg-7 3.6.6.1. Определение ключевых приложений

- •3.6.6.2. Модель интерфейса

- •3.6.7. Ключевые приложения против приложений реального мира

- •Приложение а. Словарь и сокращения

- •2.5.3 Архитектура мультимедиа mpeg-21 Семенов ю.А. (гнц итэф)

- •Обзор цифровых объектов

- •Декларация цифрового объекта

- •Контейнер

- •Компонент

- •Идентификация цифрового объекта

- •Идентификация цифровых объектов

- •Идентификация различных схем описания

- •Идентификация различных типов цифровых объектов

- •Защита и управление правами интеллектуальной собственности (ipmp)

- •Язык описания прав

- •Модель данных mpeg rel

- •Принципал

- •Условие

- •Соотношение с терминологией mpeg

- •Адаптация цифрового объекта

- •Формат файлов

- •Устойчивая ассоциация идентификации и описания с цифровыми объектами

- •2.6 Методы сжатия информации Семенов ю.А. (гнц итэф)

- •2.6.1 Алгоритм Зива-Лемпеля Семенов ю.А. (гнц итэф)

- •2.6.2 Локально адаптивный алгоритм сжатия Семенов ю.А. (гнц итэф)

- •2.6.3 Сжатие данных с использованием преобразования Барроуза-Вилера Семенов ю.А. (гнц итэф)

- •2.6.4 Метод Шеннона-Фано Семенов ю.А. (гнц итэф)

- •2.6.5 Статический алгоритм Хафмана Семенов ю.А. (гнц итэф)

- •2.7 Обнаружение ошибок Семенов ю.А. (гнц итэф)

- •2.8 Коррекция ошибок Семенов ю.А. (гнц итэф)

- •Циклические коды

- •Линейные блочные коды

- •Метод коррекции ошибок fec (Forward Error Correction)

- •Введение в коды Рида-Соломона: принципы, архитектура и реализация

- •Свойства кодов Рида-Соломона

- •Ошибки в символах

- •Декодирование

- •Преимущество кодирования

- •Архитектура кодирования и декодирования кодов Рида-Соломона

- •Арифметика конечного поля Галуа

- •Образующий полином

- •Архитектура кодировщика

- •Архитектура декодера

- •Вычисление синдрома

- •Нахождение позиций символьных ошибок

- •Нахождение значений символьных ошибок

- •Реализация кодировщика и декодера Рида-Соломона Аппаратная реализация

- •Программная реализация

- •2.9 Видеоконференции по каналам Интернет и isdn Семенов ю.А. (гнц итэф)

- •2.9.1 Используемые стандарты Семенов ю.А. (гнц итэф)

- •2.10 Статистическая теория каналов связи Семенов ю.А. (гнц итэф)

- •2.10.2. Канал связи с изменяющимися состояниями

- •2.10.3. Симметричный канал без памяти

- •3 Каналы передачи данных Семенов ю.А. (гнц итэф)

- •3.1 Кабельные каналы связи Семенов ю.А. (гнц итэф)

- •3.2 Оптоволоконные каналы и беспроводные оптические связи Семенов ю.А. (гнц итэф)

- •Беспроводные оптические каналы

- •3.3 Беспроводные (радио) каналы и сети Семенов ю.А. (гнц итэф)

- •3.4 Протокол slip и rs-интерфейсы Семенов ю.А. (гнц итэф)

- •3.4.1. Протоколы rs

- •3.4.1 Интерфейсная шина FireWire (ieee1394) Семенов ю.А. (гнц итэф)

- •Особенности ieee - 1394

- •Архитектура ieee-1394

- •.5 Протокол ppp Семенов ю.А. (гнц итэф)

- •3.6 Протокол g.703 Семенов ю.А. (гнц итэф)

- •3.7 Дерево Штайнера Семенов ю.А. (гнц итэф)

- •4 Сети передачи данных. Методы доступа Семенов ю.А. (гнц итэф)

- •Топология

- •Метод доступа к сети

- •Принципы построения сетевых программных интерфейсов

- •Очереди fifo

- •Приоритетное обслуживание очередей (pq)

- •Обычное обслуживание очередей (сq)

- •Справедливые очереди (wfq)

- •Справедливые очереди базирующиеся на классах (cbwfq)

- •Очереди с малой задержкой (llq)

- •Методы работы в условиях перегрузки

- •Алгоритм leaky bucket ("дырявое ведро")

- •Алгоритм Token Bucket ("маркерное ведро")

- •4.1 Локальные сети (обзор) Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •4.1.1.1 Архитектура сетей Ethernet Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •Гигабитный Ethernet (ge)

- •40 Гигабит/сек технологии

- •4.1.1.3 Интернет в Ethernet Семенов ю.А. (гнц итэф)

- •4.1.1.4 Повторители, мосты, мультиплексоры, переключатели и маршрутизаторы Семенов ю.А. (гнц итэф)

- •4.1.1.5 Алгоритмы и применения сетей p2p Семенов ю.А. (гнц итэф)

- •Определения:

- •Р2р файлообменные сети

- •P2p телевидение

- •Проблемы безопасности

- •Семенов ю.А. (гнц итэф)

- •4.1.3 Ieee 802.4 (Маркерная шина) Семенов ю.А. (гнц итэф)

- •4.1.4 Сети управления и сбора данных в реальном масштабе времени (can) Семенов ю.А. (гнц итэф)

- •4.1.5 Локальные сети ArcNet Семенов ю.А. (гнц итэф)

- •4.1.6 Сети fddi Семенов ю.А. (гнц итэф)

- •4.1.7 Параллельный сетевой интерфейс hippi Семенов ю.А. (гнц итэф)

- •4.1.8 Сети ieee 802.11 Семенов ю.А. (гнц итэф)

- •Безопасность в режиме pre-shared key

- •4.1.8.1 Мобильные телекоммуникации Семенов ю.А. (гнц итэф)

- •4.1.8.2 Стандарт широкополосной беспроводной связи ieee 802.16 Семенов ю.А. (гнц итэф)

- •1. Краткие характеристики стандарта 802.16

- •2. Сообщения управления мас

- •3. Сообщение дескриптора нисходящего канала (dcd)

- •Идентификатор нисходящего канала

- •4. Сообщение привязки нисходящего канала (dl-map)

- •6. Сообщение привязки восходящего канала(ul-map)

- •7. Сообщение запроса диапазона (rng-req)

- •Идентификатор нисходящего канала

- •Ожидание до завершения

- •8. Сообщение отклика на запрос диапазона (rng-rsp)

- •9. Сообщение запроса регистрации (reg-req)

- •10. Сообщение отклика регистрации reg-rsp

- •Возможности ss

- •11. Сообщения управления ключами конфиденциальности (pkm-req/pkm-rsp)

- •Атрибуты

- •12. Сообщение добавления ассоциации безопасности (sa Add)

- •13. Сообщение запроса авторизации (Auth Request)

- •14. Сообщение отклика авторизации (Auth Reply)

- •15. Сообщение отклонения авторизации (Auth Reject)

- •16. Сообщение запроса ключа

- •17. Сообщение отклика на запрос ключа

- •18. Сообщение отклонение ключа

- •19. Сообщение недействительности авторизации

- •20. Сообщение tek Invalid

- •21. Информационное сообщение аутентификации (Authent Info)

- •22. Сообщение запроса динамического добавления сервиса dsa-req)

- •Id транзакции

- •Id транзакции

- •Последовательность hmac

- •26. Dsa, инициированное ss

- •27. Dsa, инициированное bs

- •28. Сообщение подтверждения для динамического добавления сервиса (dsa-ack)

- •Id транзакции

- •29. Сообщение запроса dsc-req

- •30. Сообщение отклика динамического изменения сервиса (dsc-rsp)

- •Параметры сервисного потока

- •31. Сообщение подтверждения для динамического изменения сервиса (dsc-ack)

- •32. Сообщение запроса динамического аннулирования сервиса (dsd-req)

- •Id сервисного потока

- •33. Сообщение отклика на запрос динамического аннулирования сервиса (dsd-rsp)

- •Id сервисного потока

- •34. Сообщение запроса включения/удаления из списка мультикастного запроса (mca-req)

- •35. Сообщение отклика на запрос включения/удаления из списка мультикастного запроса (mca-rsp)

- •36. Сообщение запроса изменения профайла нисходящего канала (dbpc-req)

- •37. Сообщение отклика на изменение профайла нисходящего канала (dbpc-rsp)

- •38. Сообщение команды сброса (res-cmd)

- •39. Сообщение запроса базовых возможностей ss (sbc-req)

- •40. Сообщение отклика на запрос базовых возможностей (sbc-rsp)

- •41. Сообщение сверки часов (clk-cmp)

- •Порядковый номер

- •Результат сверки часов

- •42. Сообщение команды De/Re (dreg-cmd)

- •43. Сообщение о получении dSx (dsx-rvd)

- •44. Сообщение завершения копирования посредством tftp конфигурационного файла (tftp-cplt)

- •45. Сообщение отклика на уведомление о завершении копирования конфигурационного файла (tftp-rsp)

- •Специфические расширения поставщика

- •46. Сообщение запроса ключа

- •47. Сообщение отмены arq

- •48. Сообщение сброса arq

- •49. Формат сообщения (req-req) запроса результата измерения для канала

- •50. Формат сообщения (rep-req) о результате измерения для канала

- •51. Формат сообщения конфигурирования сеточной (mesh) сети (msh-ncfg)

- •Xmt Holdoff Exponent (показатель)

- •Id узла bs

- •52. Сообщение входа в сеточную сеть (msh-nent)

- •Id узла инициатора

- •53. Сообщение распределенной сеточной диспетчеризации (msh-dsch)

- •Флаг координации

- •Флаг запрос/отклик

- •Следующий Xmt Mх соседа

- •Показатель Xmt Holdoff соседа

- •Id узла соседа

- •Информационный элемент диспетчеризации msh-dsch

- •55. Информационный элемент запроса msh-dsch

- •Id канала

- •56. Информационный элемент возможностей msh-dsch

- •57. Информационный элемент предоставления msh-dsch

- •58. Сообщение централизованной диспетчеризации сетки (msh-csch)

- •Порядковый номер конфигурации

- •59. Сообщение конфигурации централизованной маршрутизации сетки (msh-cscf)

- •60. Запрос/отклик обратной связи канала aas (aas-fbck-req/rsp)

- •Литература

- •Семенов ю.А. (гнц итэф)

- •Литература

- •4.1.9 Сети dqdb (двойная шина с распределенной очередью) Семенов ю.А. (гнц итэф)

- •4.1.10 Сети с многокаскадными соединениями Семенов ю.А. (гнц итэф)

- •4.1.11 Сети 100Base-vg Семенов ю.А. (гнц итэф)

- •4.1.12 Канальный протокол Fibre Channel Семенов ю.А. (гнц итэф)

- •4.1.14 Адаптивные, кольцевые, высокоскоростные сети ieee 802.17 Семенов ю.А. (гнц итэф) Обзор

- •4.2 Наложенные сети Семенов ю.А. (гнц итэф)

- •4.2.1 Протоколы Novell (ipx/spx) Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •4.2.1.3 Протокол ядра NetWare (ncp) Семенов ю.А. (гнц итэф)

- •4.2.1.4 Протокол межсетевой передачи больших пакетов (lip) Семенов ю.А. (гнц итэф)

- •4.2.1.5 Служба каталогов NetWare (nds) Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •Семенов ю.А. (гнц итэф)

- •Протокол wins

- •4.3 Региональные сети Семенов ю.А. (гнц итэф)

- •4.3.1 Эталонная сетевая модель iso Семенов ю.А. (гнц итэф)

- •4.3.2 Протоколы сетей X.25 Семенов ю.А. (гнц итэф)

- •4.3.3 Интегрированные сети isdn Семенов ю.А. (гнц итэф)

- •4.3.4 Протокол Frame Relay Семенов ю.А. (гнц итэф)

- •4.3.5 Протоколы сетей atm Семенов ю.А. (гнц итэф)

- •4.3.6 Синхронные каналы sdh/sonet Семенов ю.А. (гнц итэф)

- •4.3.7 Модемы Семенов ю.А. (гнц итэф)

- •4.4 Интернет Семенов ю.А. (гнц итэф)

- •4.4 Интернет Семенов ю.А. (гнц итэф)

2.10.2. Канал связи с изменяющимися состояниями

Как было указано выше, канал характеризуется условными распределениями З2, задающими вероятности тех или иных искажений посылаемого сигнала х1. Несколько изменим схему канала связи, считая, что имеется некоторое множество Z возможных состояний z канала связи, причем если канал находится в некотором состоянии z и на входе возникает сигнал x1, то независимо от других предшествующих обстоятельств канал переходит в другое состояние z1. Этот переход подвержен случайностям и описывается условными распределениями P(C|x1, z) (P(C|x1, z) - вероятность того, что новое состояние z1 будет входить в множество C Z). При этом уже считается, что выходной сигнал х2 однозначно определяется состоянием канала z1, т.е. существует некоторая функция = (z) на пространстве z возможных состояний канала такая, что х2= (z1). Эта более общая схема позволяет учитывать те изменения, которые в принципе могут возникать в канале по мере его работы.

Рассмотрим стационарный режим работы канала связи. Предположим, что последовательно передаваемые сигналы …., 1(-1), 1(0), 1(1),…, соответствующие состояниям канала …, (-1), (0), (1),…, и определяемые ими сигналы …, 2(-1), 2(0), 2(1),…, на выходе образуют стационарные и стационарно связанные случайные последовательности. Величина С=supI( 1, 2), где I( 1, 2), означает скорость передачи информации о стационарной последовательности {1(n)} последовательностью { 2(n)} и верхняя грань берется по всем допустимым распределениям вероятностей входной последовательности {1(n)}, называется пропускной способностью канала связи.

Предположим, что поступающие на вход канала связи сообщения { 0(n)}, n =…, -1, 0, 1 ,…, образуют случайную последовательность. Будем считать правило кодирования заданным, если при всех k, m и k1,…, km k определены условные вероятности

P{ 1(k1) B1,…, 1 (km) Bm| 0(-∞ ,k)}

Того, что при поступлении последовательности сообщений

0(-∞ ,k) = …, 0(k-1), 0(k)

на соответствующих местах будут переданы сигналы 1(k1),…, 1(km), входящие в указанные множества B1, …, Bm. Эти вероятности считаются стационарными в том смысле, что они не меняются при одновременной замене индексов k и k1,…,km на k+l и k1+l,…,km+l при любом целом l. Аналогичными вероятностями p{ 3(k1) D1,…, 3(km) Dm| 2(-∞ ,k)} задается правило декодирования.

Определим величину H формулой H = inf I( 0, 3), где I( 0, 3) - скорость передачи информации о стационарной последовательности {0(n)} последовательностью {3(n)}, n = …, -1, 0, 1,… (эти последовательности предполагаются стационарно связанными), и нижняя грань берется по всем допустимым распределениям вероятностей, удовлетворяющим требованиям точности передачи {0(n)} { 3(n)}.

Неравенство H C является необходимым условием возможности передачи

{ 0(n)} { 1(n)} { 2(n)} { 3(n)}.

Напомним, что каждое сообщение 0(n) представляет собой некоторый элемент х0 из совокупности Х0. Можно интерпретировать Х0 как некоторый алфавит, состоящий из символов х0. Предположим, что этот алфавит Х0 является конечным и требование точности передачи состоит в безошибочном воспроизведении передаваемых символов:

P{ 3(k) = 3(k)} =1 для любого целого k.

Предположим также, что имеется лишь конечное число входных сигналов х1 и состояний канала z. Обозначим состояния канала целыми числами 1, 2, …, N, и пусть p(k, x1,j) - соответствующие вероятности перехода из состояния k в состояние j при входном сигнале x1:

p(k,x1,j) = P{ (x+1) = j| (n)=k, 1(n+1)=x1}.

Дополнительно предположим, что любые произведения вида

p(k0,x1(1),k1)p(k1,x1(2),k2)… p(kn-1,x1(n),kn)

являются стохастическими матрицами, задающими эргодические цепи Маркова. Это условие будет выполнено, если, например, каждая из переходных матриц {p(k,x1,j)} имеет положительный коэффициент эргодичности. Тогда при выполнении неравенства H<C и соблюдении условия эргодичности стационарной последовательности { 0(n)} сообщений на входе передача возможна с точностью до любого >0, т.е. при соответствующих способах кодирования и декодирования принимаемая последовательность сообщений { 3(n)} будет обладать тем свойством, что p{3(k) 0(k)} < для любого целого k.

Пусть 1 = {

(t), t T1} и

2= { (t), t

T2} - два семейства случайных

величин, имеющих совместное гауссово

распределение вероятностей, и пусть H1

и H2 - замкнутые линейные оболочки

величин (t), t T1,

и (t), t T2,

в гильбертовом пространстве L2

(). Обозначим буквами

P1 и P2 операторы проектирования

на пространства H1 и H2 и

положим P(1) = P1P2P1,

P(2) = P2P1P2. Количество

информации I(1,

2) о семействе величин 1,

содержащееся в семействе 2,

конечно тогда и только тогда, когда один

из операторов P(1) или P(2)

представляет собой ядерный оператор,

т.е. последовательность

1, 2,…

его собственных значений (все они

неотрицательны) удовлетворяет условию

![]() .

При этом

.

При этом

.

.

В случае, когда 1 и 2 образованы конечным числом гауссовых величин:

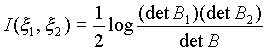

1={ (1),…, (m)}, 2 = { (m+1),…, (m+n)}, причем корреляционная матрица B общей совокупности (1),…, (m+n) является невырожденной, количество информации I( 1, 2) может быть выражено следующей формулой:

,

,

где B1 и B2 - корреляционные матрицы соответствующих совокупностей 1 и 2.

Гауссовы распределения обладают следующим экстремальным свойством. Для произвольных распределений вероятностей величин

1 = { (1), …, (m)} и 2 = { (m+1), …, (m+n)}

с соответствующими корреляционными матрицами B1, B2 и B количество информации I( 1, 2) удовлетворяет неравенству

![]()

Пусть = ( 1,…, n) и = ( 1,…,n) - векторные случайные величины в n-мерном евклидовом пространстве X и (x,y) - некоторая неотрицательная функция, определяющая условие близости величин и , которое выражается следующим соотношением:

M, ) .

Величину H=H, определенную как H = inf I(, ), обычно называют -энтропией случайной величины (нижняя грань берется по всем случайным величинам , удовлетворяющим указанному условию -близости случайной величине ).

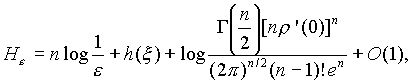

Пусть (x,y) = (|x-y|) и существует производная ’(0), 0<’(0)<∞. Тогда при 0 имеет место асимптотическая формула, в которой логарифмы берутся по основанию e:

где () - гамма функция и h - дифференциальная энтропия случайной величины :

(p(x) - плотность

распределения вероятностей, удовлетворяющая

весьма широким условиям, которые

выполняются, например, если плотность

p(x) ограничена

и h( ) > -∞ ).

Пусть

(,

> 0)

(,

> 0)

Тогда

В частности, при =2, =1 имеет место асимптотическая формула

Пусть пара случайных процессов (

1(t),

2(t)) образует стационарный

в узком смысле процесс,

[u,v] - совокупность значений

(t), u

t v, и

пусть

![]() -

условное количество информации о

процессе 1=

-

условное количество информации о

процессе 1=![]() ,

содержащееся в отрезке

,

содержащееся в отрезке

![]() процесса

2.

Среднее количество указанной информации

представляет собой линейно растущую

функцию от t:

процесса

2.

Среднее количество указанной информации

представляет собой линейно растущую

функцию от t:

![]()

Фигурирующая здесь величина I(, ) называется средней скоростью передачи информации стационарным процессом о стационарном процессе 1 или просто - скоростью передачи информации.

Скорость передачи информации I(1,2)

обладает рядом свойств, аналогичных

свойствам количества информации. Но

она имеет и специфические свойства. Так

для всякого сингулярного случайного

процесса 2,

т.е. такого процесса, все значения

2(t) которого являются

функциями от совокупности величин

![]() (t0

может быть выбрано любым), имеет место

равенство I(

1,

2)=0.

(t0

может быть выбрано любым), имеет место

равенство I(

1,

2)=0.

Для всякого регулярного случайного процесса 2 равенство I(1,2)=0 справедливо лишь тогда, когда случайный процесс 1 не зависит от процесса 2 (это говорит о том, что в некоторых случаях I(1,2) I( 2, 1) ).

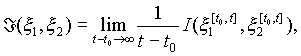

При дополнительных условиях типа регулярности скорость передачи информации I( 1, 2) совпадает с пределом

,

,

где

![]() -

количество информации об отрезке

процесса

-

количество информации об отрезке

процесса

![]() ,

заключенное в

,

заключенное в

![]() .

Так будет, например тогда, когда время

меняется дискретно, а отдельные величины

1(t) и 2(t)

могут принимать лишь конечное число

различных значений или когда распределение

вероятностей процессов 1

и 2 является

гауссовым. В случае непрерывного времени

t так будет для гауссовых процессов,

когда спектральная плотность f()

процесса 2(t)

удовлетворяет условию

.

Так будет, например тогда, когда время

меняется дискретно, а отдельные величины

1(t) и 2(t)

могут принимать лишь конечное число

различных значений или когда распределение

вероятностей процессов 1

и 2 является

гауссовым. В случае непрерывного времени

t так будет для гауссовых процессов,

когда спектральная плотность f()

процесса 2(t)

удовлетворяет условию

0< c 2nf( ) c < ∞

Пусть стационарный процесс = (t) представляет собой последовательность величин, каждая из которых принимает значения из некоторого алфавита x, состоящего из конечного числа символов x1, x2,…,xn. Предположим, что вероятность появления на фиксированном месте определенного символа xi есть pi, а вероятность появиться за ним символу xj не зависит от предшествующих xi значений и есть pij:

P{ (t) = xi} = pi, P{(t+1) = xi xi|(t) = xi, (t-1),…, } = pij

Другими словами = (t) - стационарная цепь Маркова с переходными вероятностями {pij} и стационарным распределением {pi}. Тогда скорость передачи информации стационарным процессом (t) будет

I(,)

= -

![]()

В частности, если = (t) - последовательность независимых величин (в случае pij = pj), то

I(,)

= -

![]()

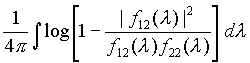

Пусть 1 = 1(t) и 2 = 2(t) - стационарные гауссовы процессы со спектральными плотностями f11(), f22() и взаимной спектральной плотностью f12() причем процесс 2 = 2(t) является регулярным. Тогда

I(1,

2)

= -

Рассмотрим следующее условие близости гауссовых стационарных процессов 1(t) и 2(t):

M|1(t) - 2(t)|2 2

Наименьшая скорость передачи информации H = infI(1,2), совместимая с указанным условием “-точности”, выражается следующей формулой:

где

где

,

,

а параметр 2 определяется из равенства

![]() .

.

Эта формула показывает, какого типа спектральная плотность f22() должна быть у регулярного стационарного процесса 2(t), который несет минимальную информацию I (1, 2) H о процессе 1(t). В случае дискретного времени, когда f11( ) 2 при всех , - , нижняя грань H скорости передачи достигается для такого процесса 2 (t) (со спектральной плотностью f22(), задаваемой приведенной выше формулой), который связан с процессом 1(t) формулой 2(t) = 1(t) + (t), где (t) - стационарный гауссов шум, не зависящий от процесса 2(t); в общем случае формула f22() задает предельный вид соответствующей спектральной плотности регулярного процесса 2(t).

В случае, когда спектральная плотность f11() приближенно выражается формулой

соответствующая минимальная скорость

передачи информации H

может быть вычислена по приближенной

формуле

,

2 = M[(t)]2.

,

2 = M[(t)]2.