- •1.1.2. Метод Флетчеру-Рівсу

- •1.1.3. Модифікація методу Флетчеру-Рівсу для мінімізаціі неквадратичної цільової функції

- •1.2. Методи Ньютону

- •1.2.1. Загальна характеристика методів Ньютону

- •1.2.2. Метод Ньютону

- •1.2.3. Методи з регулюванням кроку (методи Ньютону-Рафсона).

- •А лгоритм методу Ньютону-Рафсона з дробленням кроку.

- •А лгоритм методу Ньютону-Рафсона з вибором оптимального кроку.

- •1.2.3. Модифікації методу Ньютону

- •С хема модифікації I методу Ньютону.

- •С хема модифікації II методу Ньютону.

- •2. Завдання на лабораторну роботу

- •3. Варіанти завдань

- •Метод Ньютону;

Лабораторна робота № 4

Тема: Методи багатомірної оптимізації 1-го та 2-го порядку. Методи спряжених градієнтів та Ньютону

Мета роботи: знайомство з методами багатомірної безумовної оптимізації другого порядку й близького до них по ефективності методу спряжених градієнтів, освоєння й порівняння ефективності їхнього застосування для конкретних цільових функцій.

1. Короткі теоретичні відомості

Розглядаються методи мінімізації:

метод Флетчеру-Рівса;

модифікація методу Флетчеру-Рівсу для мінімізації неквадратичної цільової функції.

метод Ньютону;

метод Ньютону-Рафсону із дробленням кроку;

метод Ньютону-Рафсону з оптимальним кроком;

модифікація I методу Ньютону;

модифікація II методу Ньютону.

Вступні зауваження

Матрицею

Гесе

![]() подвійно диференційованої

в точці x

функції

подвійно диференційованої

в точці x

функції

![]() називається матриця

часткових похідних другого порядку,

обчислених в даній точці:

називається матриця

часткових похідних другого порядку,

обчислених в даній точці:

Якщо позначити

![]() ,

то отримаємо наступний запис:

,

то отримаємо наступний запис:

Як видно, матриця є симетричною.

1.1 Метод спряжених градієнтів

1.1.1. Загальна характеристика методів спряжених градієнтів

Метод спряжених градієнтів відноситься до групи методів спряжених напрямків. Цей метод відноситься до методів першого порядку, тобто використовує інформацію тільки по першій похідній функції, що мінімізується. Однак метод спряжених градієнтів відрізняється від градієнтних методів більш високою швидкістю збіжності, що при певних припущеннях щодо цільової функції, наближається до швидкості збіжності методу Ньютону.

Два вектори x і y називають Н-спряженими (або спряженими стосовно матриці Н) або Н-ортогональними, якщо скалярний добуток

(x, H·y) = 0.

(1)

Спряженість можна вважати узагальненням поняття ортогональності. Справді, коли Н=Е, х та y відповідно до рівняння (1) ортогональні.

Розглянемо квадратичну функцію n змінних

![]() .

.

(2)

з додатньо визначеною n×n матрицею. Виявляється, що квадратична функція (2) може бути мінімізованою методом спряжених напрямків не більш ніж за n кроків.

Щоб скористатися цим методом мінімізації квадратичної функції (2) потрібно знати n-взаємно спряжених напрямків S0, S1, …, Sn-1. Ефективність таких напрямків — самостійна проблема. Існує багато взаємно спряжених напрямків S0, S1, …, Sn-1 і способів їхньої побудови. Нижче викладається метод спряжених градієнтів Флетчера-Рівса, у якому вибір Н-спряжених напрямків здійснюється разом з одномірною мінімізацією f(х) по α.

1.1.2. Метод Флетчеру-Рівсу

Характеристика методу Флетчеру-Рівсу

Цей метод використовує послідовність напрямків пошуку, кожна з яких є лінійною комбінацією антиградієнта в поточній точці й попередньому напрямку спуску. Метод застосовується до квадратичної цільової функції

.

При мінімізації її методом Флетчеру-Рівсу вектори Sk обчислюються за формулами

![]() ,

,

![]() .

.

Величини βk-1 вибираються так, щоб напрямки Sk, Sk-1 були Н-спряженими.

Точка хk-1 визначається в результаті мінімізації функції f(х) в напрямку Sk, що виходить із точки xk, тобто

![]() ,

,

де αk доставляє мінімум по αk функції f(xk, α ·Sk).

Отже, пропонована процедура мінімізації функції f(x) виглядає в такий спосіб. У заданій точці x0 обчислюється антиградієнт S0= –f '(x0). Здійснюється одномірна мінімізація в цьому напрямку й визначається точка x1. У точці x1 знову обчислюється антиградієнт –f '(x1). Оскільки ця точка доставляє мінімум функції f(x) уздовж напрямку S0= –f'(x0), вектор f '(x1) ортогональний до f '(x0). Потім за відомим значенням f '(x1) по формулі (11) обчислюється вектор S1, що за рахунок вибору β0 буде Н-спряженим до S0. Далі відшукується мінімум функції f(х) уздовж напрямку S1 і т.д.

А лгоритм

методу Флетчеру-Рівсу

лгоритм

методу Флетчеру-Рівсу

Крок 1.

При k=0

задається початкове наближення x0.

Обчислення антиградієнта

![]() .

.

Крок 2.

Розв'язання задачі одномірної мінімізації по функції f(xk+·Sk), в результаті чого визначається величина кроку k і точка xk+1=xk+k·Sk.

Крок 3.

Обчислення величин f(xk+1) і f '(xk+1).

Крок 4.

Якщо

![]() ,

то xk+1 —

розв'язання задачі.

,

то xk+1 —

розв'язання задачі.

Інакше визначаємо новий напрямок пошуку: Sk+1 зі співвідношення :

![]() .

.

Далі k=k+1 і перехід до кроку 2.

Це і є остаточний вид алгоритму Флетчера-Рівса. Як було помічено раніше, він знаходить мінімум квадратичної функції не більш ніж за n кроків.

1.1.3. Модифікація методу Флетчеру-Рівсу для мінімізаціі неквадратичної цільової функції

Метод

Флетчера-Рівса може застосуються для

мінімізації й неквадратичних функцій.

Він є методом першого порядку й у той

же час швидкість його збіжності

квадратична. Зрозуміло, якщо цільова

функція не квадратична, метод уже не

буде кінцевим. Тому після (n+1)-й

ітерації процедура повторюється із

заміною x0

на xn+1,

а рахунок закінчується при

![]() ,

де ε —

задане число. При мінімізації неквадратичних

функцій звичайно застосовується наступна

модифікація методу Флетчеру-Рівсу.

,

де ε —

задане число. При мінімізації неквадратичних

функцій звичайно застосовується наступна

модифікація методу Флетчеру-Рівсу.

С хема

алгоритму для неквадратичних цільових

функцій.

хема

алгоритму для неквадратичних цільових

функцій.

Крок 1.

При k=0 введення початкового наближення x0 і умови зупинки ε3. Обчислення антиградієнта S0= –f '(x0).

Крок 2.

Розв'язання задачі одномірної мінімізації по α функції f(xk+·Sk), в результаті чого визначається величина кроку k і точка xk+1=xk+k·Sk.

Крок 3.

Обчислення величин f(xk+1) і f '(xk+1).

Крок 4.

Якщо

![]() ,

то точка xk+1 —

розв'язок задачі й на цьому пошук

закінчується.

,

то точка xk+1 —

розв'язок задачі й на цьому пошук

закінчується.

Інакше визначається коефіцієнт βk по формулі:

Крок 5.

Обчислення Sk+1

по формулі

![]() .

.

Привласнюється k=k+1 і перехід до кроку 2.

Тут i — множина індексів, i={0, n, 2n, 3n, …}. Значення k, для яких βk=0, називають моментами відновлення методу. Таким чином, відновлення методу відбувається через кожні n кроків.

1.2. Методи Ньютону

1.2.1. Загальна характеристика методів Ньютону

Методи Ньютону відносяться до методів другого порядку, тобто використовують другі частинні похідні цільової функції f(x). Всі вони є прямим узагальненням відомого методу Ньютону відшукання кореня рівняння:

φ(x)=0,

(3)

де φ(x) — скалярна функція скалярного аргументу x.

Метод Ньютону відшукання кореня рівняння описується наступною рекурентною формулою:

![]() .

.

(4)

Цей метод ще називають методом дотичних для розв'язання рівняння (3).

Нехай тепер φ(x) — n-мірна вектор-функція векторного аргументу x тієї ж розмірності. Тоді для розв'язання системи рівнянь φ(x)=0 ми можемо використовувати ітераційний процес, аналогічний (4):

![]()

(5)

де

![]() —

квадратна матриця n×n.

—

квадратна матриця n×n.

Розглянемо тепер випадок, коли вектор-функція φ(x) є градієнтом деякої скалярної функції f(x), тобто

φ(x)=f '(x).

Прирівнюючи її до нуля, приходимо до системи рівнянь, яка визначає координати стаціонарних точок функції f(x). Формула методу Ньютону для розв'язання цієї системи виглядає так:

![]()

(6)

і отримується заміною в (6) φ(xk) на f '(x).

Ітераційний процес (6) будує послідовність точок {xk}, що при певних припущеннях сходиться до деякої стаціонарної точки x функції f(x), тобто до точки, у якій f '(x)=0. Якщо матриця других похідних f ''(x) позитивно визначена, ця точка буде точкою локального мінімуму функції f(x).

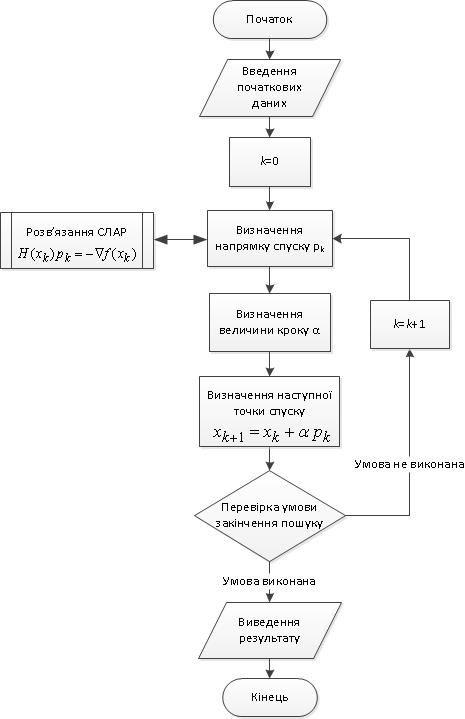

Рис. . Узагальнена схема оптимізаційних методів Ньютону