- •Интеллектуальные средства измерений

- •Часть I Нейрокомпьютерные сети

- •1 Теоретические основы нейронных сетей

- •1.1 Обзор основных свойств и функций нейронных сетей

- •1.1.1 Свойства искусственных нейронных сетей

- •1.1.2 Обучение нейронных сетей

- •1.1.3 Обобщение

- •1.1.4 Абстрагирование

- •1.1.5 Применимость

- •1.2 Терминология, обозначения и схематическое изображение искусственных нейронных сетей

- •1.3 Структура нейроных сетей

- •1.4 Обучение искусственных нейронных сетей

- •1.4.1 Обзор основных свойств обучения

- •1.4.1.1 Цель обучения

- •1.4.1.2 Обучение с учителем

- •1.4.1.3 Обучение без учителя

- •1.4.1.4 Алгоритмы обучения

- •1.4.2 Процедура обратного распространения

- •1.4.2.1 Сетевые конфигурации

- •1.4.2.2 Многослойная сеть

- •1.4.2.3 Проход вперед

- •1.4.2.4 Обратный проход. Подстройка весов выходного слоя

- •1.4.2.5 Подстройка весов скрытого слоя

- •1.4.2.6 Добавление нейронного смещения

- •1.4.2.7 Импульс

- •1.4.2.8 Паралич сети

- •1.4.2.9 Локальные минимумы

- •1.4.2.10 Размер шага

- •1.4.2.11 Временная неустойчивость

- •1.4.3 Сети встречного распространения

- •1.4.3.1 Структура сети

- •1.4.3.2 Нормальное функционирование

- •1.4.3.2.1 Слои Кохоненна

- •1.4.3.2.2 Слой Гроссберга

- •1.4.3.3 Обучение слоя Кохонена

- •1.4.3.3.1 Предварительная обработка входных векторов

- •1.4.3.3.2 Выбор начальных значений весовых векторов

- •1.4.3.3.3 Режим интерполяции

- •1.4.3.3.4 Статистические свойства обученной сети

- •1.4.3.3 Обучение слоя Гроссберга

- •1.4.3.4 Сеть встречного распространения полностью

- •1.4.4 Стохастические методы

- •1.4.4.1 Использование обучения

- •1.4.4.2 Больцмановское обучение

- •1.4.5 Сети Хопфилда

- •1.4.5.1 Бинарные системы

- •1.4.5.2 Устойчивость

- •1.4.5.3 Ассоциативная память

- •1.4.5.4 Обобщенные сети

1.4.1.4 Алгоритмы обучения

Большинство современных алгоритмов обучения выросло из концепций Хэбба [4]. Им предложена модель обучения без учителя, в которой синоптическая сила (вес) возрастает, если активированы оба нейрона, источник и приемник. Таким образом, часто используемые пути в сети усиливаются и феномен привычки и обучения через повторение получает объяснение.

В искусственной нейронной сети, использующей обучение по Хэббу, наращивание весов определяется произведением уровней возбуждения передающего и принимающего нейронов. Это можно записать как:

wij(n+1) = w(n) + αOUTi OUTj;

где wij(n) – значение веса от нейрона i к нейрону j до подстройки, wij(n+1) – значение веса от нейрона i к нейрону j после подстройки;

α – коэффициент скорости обучения;

OUTi – выход нейрона i и вход нейрона j;

OUTj – выход нейрона j.

Сети, использующие обучение по Хэббу, конструктивно развивались, однако за последние 20 лет были развиты более эффективные алгоритмы обучения.

В настоящее время используется огромное разнообразие обучающих алгоритмов.

1.4.2 Процедура обратного распространения

1.4.2.1 Сетевые конфигурации

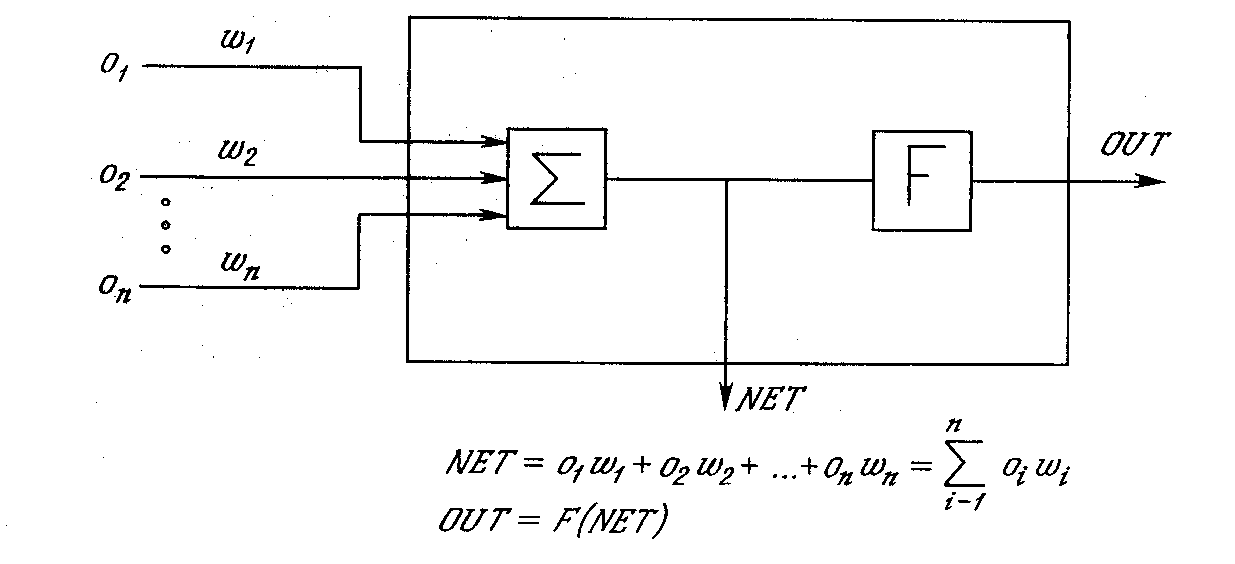

Рисунок 10 - Искусственный нейрон с активационнной функцией

На рисунке 10 показан нейрон, используемый в качестве основного строительного блока в сетях обратного распространения. Подается множество входов, идущих либо извне, либо от предшествующего слоя. Каждый из них умножается на вес, и произведения суммируются. Эта сумма, обозначаемая NET, должна быть вычислена для каждого нейрона сети. После того, как величина NET вычислена, она модифицируется с помощью активационной функции и получается сигнал OUT.

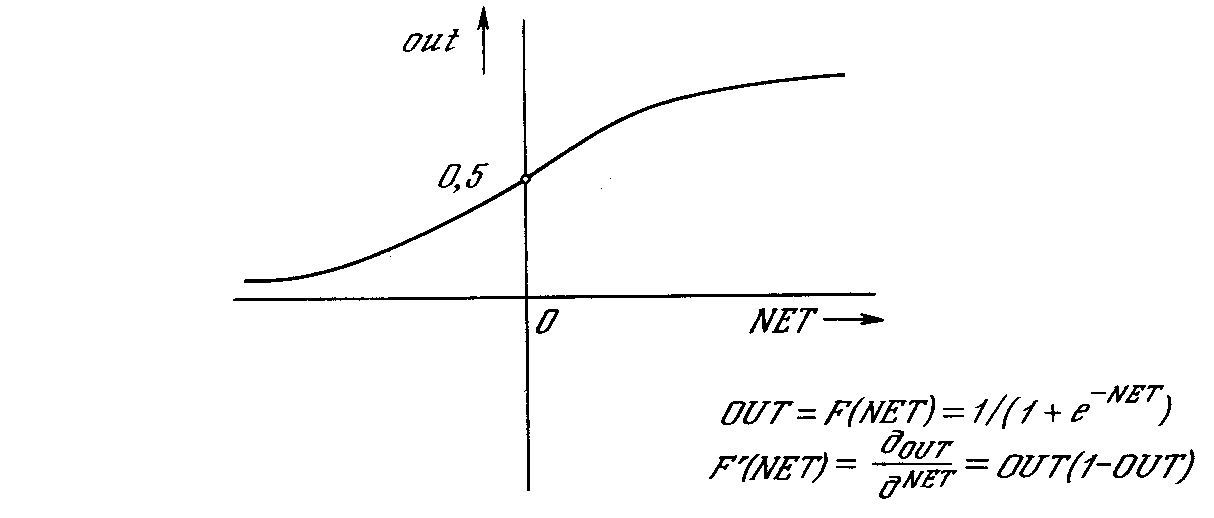

Рисунок 11 - Сигмоидальная активационная функция

На рисунке 11 показана активационная функция, обычно используемая для обратного распространения.

![]() . (1)

. (1)

Как показывает уравнение (2), эта функция, называемая сигмоидом, весьма удобна, так как имеет простую производную, что используется при реализации алгоритма обратного распространения.

![]() . (2)

. (2)

Сигмоид, который иногда называется также логистической, или сжимающей функцией, сужает диапазон изменения NET так, что значение OUT лежит между нулем и единицей. Как указывалось выше, многослойные нейронные сети обладают большей представляющей мощностью, чем однослойные, только в случае присутствия нелинейности. Сжимающая функция обеспечивает требуемую нелинейность.

В действительности имеется множество функций, которые могли бы быть использованы. Для алгоритма обратного распространения требуется лишь, чтобы функция была всюду дифференцируема. Сигмоид удовлетворяет этому требованию. Его дополнительное преимущество состоит в автоматическом контроле усиления. Для слабых сигналов (величина NET близка к нулю) кривая вход-выход имеет сильный наклон, дающий большое усиление. Когда величина сигнала становится больше, усиление падает. Таким образом, большие сигналы воспринимаются сетью без насыщения, а слабые сигналы проходят по сети без чрезмерного ослабления.