Лекции по информатике2 / Лекция №4 / Слайды №4 Информационная мера Шеннона

.docСлайды к лекции №4

1. Условная энтропия и взаимная информация.

2. Количество информации и избыточность

3. Аддитивность информационной меры

Условная энтропия и взаимная информация.

Пусть

![]() и

и

![]() - случайные величины с множеством

возможных значений

- случайные величины с множеством

возможных значений

![]()

![]()

Условной

энтропией

величины

![]() при наблюдении величины

при наблюдении величины

![]() называется

называется

![]()

Справедливы соотношения:

![]()

![]()

Взаимной

информацией

величин

![]() и

и

![]() называется

называется

![]()

Справедливы следующие соотношения:

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Если

![]() и

и

![]() независимы,

то

независимы,

то

![]() =0.

=0.

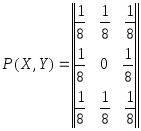

Пример 1.

Дана матрица

,

,

![]()

![]() .

.

Определить:

![]()

![]()

![]()

![]()

![]()

![]()

Решение.

По формуле полной вероятности имеем:

![]()

![]()

![]()

![]()

![]()

![]()

Следовательно,

![]()

![]()

По теореме умножения

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Следовательно,

![]()

Аналогично

![]()

![]()

![]()

Количество информации и избыточность

Количество

информации

![]() при

наблюдении случайной величины

при

наблюдении случайной величины

![]() с распределением

вероятностей

с распределением

вероятностей

![]() задается формулой Шеннона:

задается формулой Шеннона:

![]()

Единицей измерения количества информации является бит, который представляет собой количество информации, получаемое при наблюдении случайной величины, имеющей два равновероятных значения.

При равномерном

распределении

![]() количество информации задается формулой

Хартли:

количество информации задается формулой

Хартли:

![]()

Справедливы следующие соотношения:

если

![]() и

и

![]() - независимы

- независимы

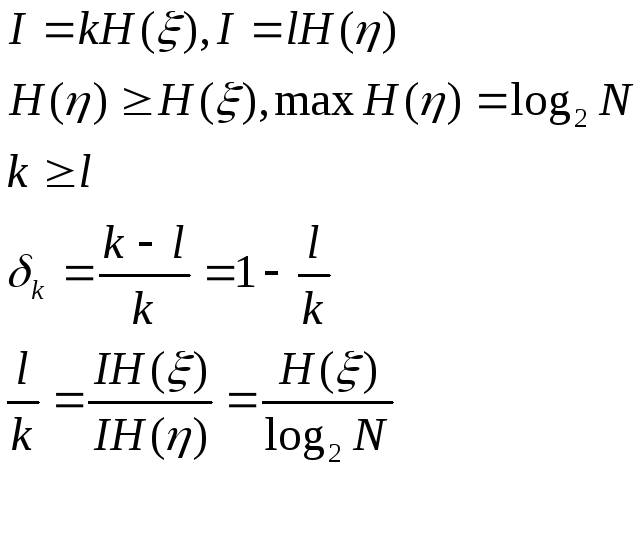

Избыточностью

называется

![]()

Пусть

поэтому

![]()

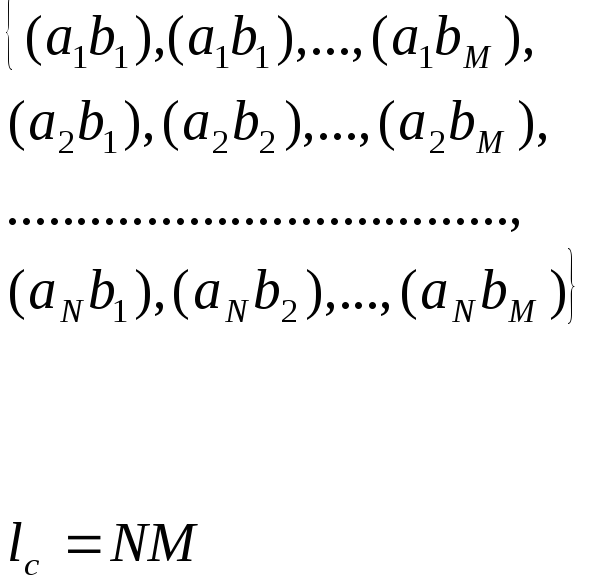

Аддитивность информационной меры

Рассмотрим два источника информации:

![]()

При одновременном наблюдении

C=

Количество символов на выходе источника

С:

![]()

Мера Хартли:

![]()

Мера Шеннона

Пусть А и В

независимы, тогда

![]()

H(C)=H(A)+H(B)