- •Электронный вариант лекций по дисциплине «Сетевые технологии»

- •Иерархия сетей.

- •Принципы организации информационных сетей.

- •Особенности информационных сетей.

- •Модель взаимодействия открытых систем.

- •Сетевые топологии.

- •Набор протоколов tcp/ip.

- •Архитектура tcp-1.

- •Ip – Internet Protocol

- •3. Протоколы транспортного уровня.

- •4. Протоколы прикладного уровня.

- •Ip-адресация.

- •Маски подсетей.

- •Представление маски подсети в виде префикса сети

- •Прикладные интерфейсы tcp/ip

- •Протоколы маршрутизации стека tcp/ip

- •Ip – Маршрутизация

- •Электронная почта в сети internet Почтовые протоколы

- •1. Протокол smtp

- •2. Протокол pop3

- •Раздел: Сетевая безопасность

- •1.Обнаружение атак на сетевом уровне

- •2. Обнаружение атак на системном уровне

- •Статистика самых распространенных атак

- •Классификация атак

- •Психологические методы доступа

- •Средства защиты компьютерных сетей

- •Раздел: «Распределенное вычисление» Организация кластеров

- •Классификация Флина.

Раздел: «Распределенное вычисление» Организация кластеров

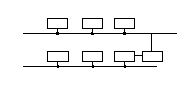

Для параллельной работы выделяют три технологии:

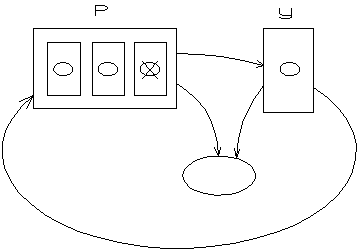

SMP (симметричные микропроцессорные системы)

Этот механизм встроен в UNIXсистемах

Config–smp(autoconf)

Grid(кластерные распределенные вычислительные системы)

У злы

находятся внутри этой сети

злы

находятся внутри этой сети

Технология Gridзавязана на сетевое взаимодействие.Gridдешевле чемSMP.

Компьютеры CRAI

Представляет

собой золотую пластину на которой 1млн.

процессоров.

Представляет

собой золотую пластину на которой 1млн.

процессоров.

Кластерные вычисления – необходима сбалансированная нагрузка между узлами.

Существует набор программ Beowulfкоторый позволяют делать кластерные вычисления в автоматическом состоянии.

Известен сервер Apacheкоторый может работать и на одном процессоре, а так же на группе процессоров.

![]() Майкрософт

работает на таком же принципе.

Майкрософт

работает на таком же принципе.

СУБД: MySQL,Oracleмогут работать на много процессорной распределенной вычислительной среде.

Для такого взаимодействия должны использоваться различные библиотеки или системы программирования архитектуры:

MPI(Message Passin Interface)

PVM()

С помощью этих библиотек можно легко построить программу работающую в много процессорной распределенной вычислительной среде.

Beowulf.

На сегодняшний день Интернет сообщество которое занимается распределенными вычислениями.

Distributed.net

Distributed.net

Была поставлена задача NASA, кто переберет 65 битный ключRCS(RCA)-американский стандарт шифрования. Система все-таки была взломана и это положило стартBPGrid.

Эти проекты выложены в Интернете:

Медицина.

Семантические направления.

Анализ экономических факторов. Финансируется крупными банками и прогнозируется экономическое положение стран.

Группа по поиску неземных цивилизаций.

Прогноз климата и погоды. Собираются данные со всех метеорологических станций и анализируются и прогнозируются.

Виды алгоритмов распределенных вычислительных систем.

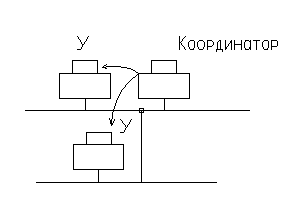

Централизованный алгоритм.

Первый процесс выбирается в качестве координатора, остальные процессы синхронизируются координатором.

Распределенный алгоритм.

Распределенный алгоритм может физически находиться на разных машинах, а централизованный алгоритм на одной машине.

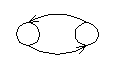

Tokenring. Все процессы в распределительной системе образуют логическое кольцо. Очередность доступа идет по кольцу: Каждый процесс знает какой у него номер и когда он может обратиться к критической секции.

Этот алгоритм наименее надежен из всех, но один из самых быстрых, т.к. нет обмена с координатором.

Чтобы обратиться к критической секции нужно сделать n-1 запрос координатору, гдеn– это процесс и получитьn-1 разрешений, таким образом затраты составляют 2(n-1).

Для выполнения распределенного алгоритма, то же самое, но объему передаваемых данных больше в 2-3 раза. Тем не менее при грамотном расположении машин прикладные расходы окупятся производителями серверов.

Сравнительная характеристика протоколов TCPиUDPдля применения их в РВ.

TCP– надежный громоздкий, КПД достигает 15-20%, аUPDболее 60%.

UPD– быстрый и ненадежный, контроль ошибок делается на уровне приложений. ЗаголовокTCPсоставляет 41 байт, аUDPменее 10 байт. Можно просчитать прикладные расходы в два конца.

Обратное

возвращение за 200 мс.

Обратное

возвращение за 200 мс.

Параллельный вычислительные системы.

Архитектура параллельных систем.

На сегодняшний день выделяют две модели программирования:

последовательная (Pascal, C++)

параллельная. Ее появление связано с появлением векторных компьютеров.

В параллельном программировании выделяют две концепции:

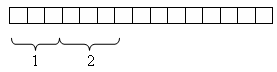

1) распараллеливание данных(dataparallel)

2) распараллеливание задач, алгоритмов(messagepassing(обмен сообщениями)).

В основе подходов лежат распараллеленные нагрузки по вычислительным процессам.

Задача просуммировать

массив.

Задача просуммировать

массив.

Все Интернет проекты работают по подходу №1.

Языки: HPFortranв нем есть особенности параллельного программирования и С*.

Особенности:

Наличие единого алгоритма который распространяется на каждый из вычислительных узлов.

Наличие единого глобального поля данных.

Минусы: Слабая синхронизация процессов.

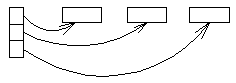

Вторая концепция. Распараллеливание задач.

Возьмем три процессора.

Для каждого вычислительного узла нужно писать свою часть алгоритма.

Плюсы: Повышенная гибкость такого подхода.

Минусы:

Повышенная сложность разработки программ для каждого узла, необходимость в отладке сразу трех программ.

На программиста ложится ответственность за равномерную загрузку процессора.

В виду большого межпроцессорного обмена сообщениями разработчику приходиться его минимизировать.

Для работы таких систем существуют отлаженные библиотеки:

Message Passing Interface(MPS).

PVM.

Обе библиотеки работают по принципу распараллеливания задач.

Плюсы: Здесь можно использовать обычный С++ и Fortran.

Программа строится линейно:

- открываем критическую секцию

- посылаем данные

- закрываем критическую секцию

Архитектура вычислительных систем для высокопроизводительных вычислений.

Архитектура компьютера – описание компонент компьютера и их взаимодействие.

Организация компьютера – описание конкретной реализации архитектуры или реализация идей в конкретном железе.

Допустим мы строим многопроцессорную систему.

Схема вычисления системы.

Проектировщик спроектировал и отдает электронщику.