Лекции по МРРиИ, Геппенер В.В. / lecture5a / informat

.docАЛГОРИТМЫ ОЦЕНКИ ИНФОРМАТИВНОСТИ ПРИЗНАКОВ

ЗАДАЧА ОЦЕНКИ ИНФОРМАТИВНОСТИ ПРИЗНАКОВ

Формирование

признаковых описаний случайных сигналов

различной природы в задачах классификации

можно рассматривать как отображение

сигнала из некоторого функционального

пространства, элементами которого

являются реализации S(t),

в векторное пространство i,

i=![]() ,

,![]() элементы

которого называются признаками.

Размерность исходного пространства i

может быть велика, что вызывает

необходимость анализа исходных описаний

с

элементы

которого называются признаками.

Размерность исходного пространства i

может быть велика, что вызывает

необходимость анализа исходных описаний

с![]() целью выявления действительно

информативных элементов и сокращения

размерности. При анализе описаний

сигналов в общем случае в качестве

признаков целесообразно рассматривать

совокупность множеств точек отрезков

целью выявления действительно

информативных элементов и сокращения

размерности. При анализе описаний

сигналов в общем случае в качестве

признаков целесообразно рассматривать

совокупность множеств точек отрезков

![]() числовой оси, отражающих степень

выраженности различных свойств этих

сигналов. Значениям признаков

числовой оси, отражающих степень

выраженности различных свойств этих

сигналов. Значениям признаков

![]() характеризующим сигнал Sj(t),

ставится в соответствие некоторый набор

элементов множеств i.

Тогда

характеризующим сигнал Sj(t),

ставится в соответствие некоторый набор

элементов множеств i.

Тогда

![]() и существует совокупность последовательностей

признаков Sj=

(

и существует совокупность последовательностей

признаков Sj=

(![]() ),

описывающих любой элемент из

множества сигналов S1(t),

S2(t),

... ,Sm(t)

при распознавании (классификации).

),

описывающих любой элемент из

множества сигналов S1(t),

S2(t),

... ,Sm(t)

при распознавании (классификации).

Задачей выбора признаков является не только сокращение размерности описаний, но и получение достаточно высокой (заданной) надежности правильного распознавания. Подавляющее большинство известных методов оценки информативности и выбора признаков в задачах распознавания сигналов делится на две большие группы: методы выбора в пространстве измерений и методы выбора в преобразованных пространствах [1]. В первом случае выбор признаков производится путем сокращения размерности исходного описания по критерию, минимизирующему ошибку классификации, а во втором – анализируется вся информация в пространстве i, из которого в другом пространстве получается минимизированное описание.

Первая группа включает методы, основанные на мерах расстояний, мерах зависимостей и мерах по евклидовым расстояниям. Ко второй группе относятся методы, использующие линейные отображения: методы дискриминантного анализа; методы, основанные на мерах разделимости, разложении Карунена-Лоэва, неортогональных преобразованиях. Общими недостатками методов обеих групп являются весьма значительный объем вычислений при решении практических задач, использование априорных вероятностей классов или функций распределения собственных областей в пространстве i либо необходимость соблюдения трудновыполнимых ограничений и др.

Ограниченность

исходных статистических выборок и, как

следствие, невозможность опоры на

состоятельные вероятностные зависимости,

требование разумности объемов

вычислительных затрат приводят к

необходимости ориентации на достаточно

простые приближенные оценки, отражающие

основные статистические свойства

признаковых описаний классов. Указанные

оценки (меры разделимости) целесообразно

задавать, опираясь на математическое

ожидание и дисперсию значений i-го

признака. Привлечение этих характеристик

вполне правомерно, поскольку они широко

применяются при решении задач распознавания

и классификации, в том числе при

формулировке критериев оценки

информативности признаков [5]-[7].

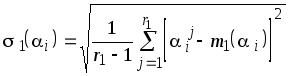

Под математическим ожиданием в данном

приложении понимается среднее значение

признака

![]() вычисляемое по статистике (выборке)

описаний сигналов одного из классов, а

выборочная дисперсия (или стандартное

отклонение) отображает разброс значений

вычисляемое по статистике (выборке)

описаний сигналов одного из классов, а

выборочная дисперсия (или стандартное

отклонение) отображает разброс значений

![]() по отношению к зафиксированному

положению образа класса на этой

координате.

по отношению к зафиксированному

положению образа класса на этой

координате.

МЕТОДЫ ОЦЕНКИ ИНФОРМАТИВНОСТИ

Рассмотрим для

удобства два класса объектов К1

и К2,

каждый из которых представлен выборками

признаковых описаний реализаций сигналов

Sj=(![]() ),

j =

),

j =![]() причем положим, что класс К1

составляют описания реализаций с

номерами j=1,2,...,r1,

а класс К2 - j

= r1+1,

r1+2,

..., r1+r2;

r1+r2=r.

Для оценки информативности признаков

в исходных описаниях сигналов предлагается

использовать совокупность мер, построенных

на статистических критериях различимости

классов с учетом расстояний между ними

и внутриклассовой "компактности"

значений признаков:

причем положим, что класс К1

составляют описания реализаций с

номерами j=1,2,...,r1,

а класс К2 - j

= r1+1,

r1+2,

..., r1+r2;

r1+r2=r.

Для оценки информативности признаков

в исходных описаниях сигналов предлагается

использовать совокупность мер, построенных

на статистических критериях различимости

классов с учетом расстояний между ними

и внутриклассовой "компактности"

значений признаков:

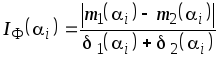

- меру, служащую одномерным критерием адекватности i-го признака для разделения двух классов и соответствующую критерию Фишера [7]:

,

где

,

где

![]() – выборочное среднее значение i

для класса К1;

– выборочное среднее значение i

для класса К1;

–

выборочное стандартное отклонение для

класса К1,

а для класса К2

значения

–

выборочное стандартное отклонение для

класса К1,

а для класса К2

значения

![]() и

и

![]() определяются аналогично при

определяются аналогично при

![]()

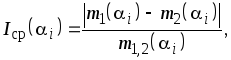

- меру,

характеризующую относительное

нормированное различие между классами

по средним значениям признаков:

где

где

![]() ;

;![]()

- меру, основанную

на применении концепции дивергенции

[7]:

где

![]() и

и

![]() – дисперсии.

– дисперсии.

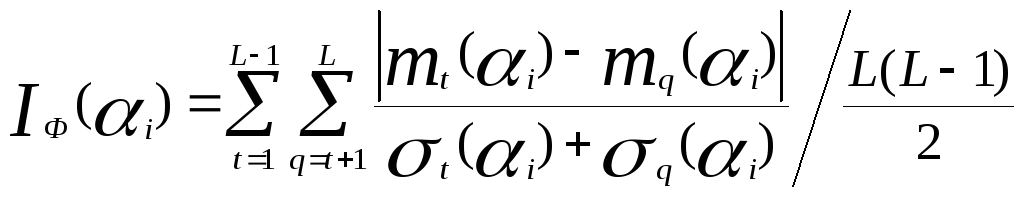

Для случая L классов (L>2) приведенные формулы позволяют получить значения мер для любой пары сравниваемых классов. Осредненные значения мер для всех классов получаются взвешенным суммированием, например

.

.

Аналогичным образом

вычисляются оценки

![]() .

По сравнению с применяемыми в известных

методах [5],

[6] направленным или случайным

перебором различных подмножеств i

с "поощрением"

и "наказанием"

отдельных признаков и определением

вероятностных зависимостей и мер

расстояний (или близости) объем вычислений

здесь относительно невелик.

.

По сравнению с применяемыми в известных

методах [5],

[6] направленным или случайным

перебором различных подмножеств i

с "поощрением"

и "наказанием"

отдельных признаков и определением

вероятностных зависимостей и мер

расстояний (или близости) объем вычислений

здесь относительно невелик.

СПИСОК ИСПОЛЬЗОВАННОЙ ЛИТЕРАТУРЫ

1). Геппенер В. В., Назаров В. Б., Яфаева Н.Ю. Алгоритм классификации на основе разнородных признаков. Л., Известия ЛЭТИ, вып. 415, 1989

2). Горелик А. Л., Гуревич И. Б., Скрипкин В. А. Современное состояние проблемы распознавания: Некоторые аспекты. Н., Радио и связь, 1985

3). Горелик Л. А., Скрипкин В. А. Методы распознавания. М., Высшая школа, 1984

4). Ту Дж., Гонсалес Р. Принципы распознавания образов. Н., Мир, 1978

5). Васильев В.И. Распознающие системы: Справ. Киев: Наук. думка, 1983.

6). Дуда Р., Харт П. Распознавание образов и анализ сцен / Пер. с англ. М.: Мир, 1976.

7). Распознавание образов: состояние и перспективы / К. Вегхаген, Р. Дейн, Ф. Грун и др.; Пер. с англ. М.: Радио и связь, 1985.

8). Растригин Л. А., Эренштейн Р. Х. Метод коллективного голосования М., Энергоиздат, 1981

9). Лбов Г.С. Методы обработки разнотипных экспериментальных данных. Новосибирск, Наука, 1981

10). Тимохин В. И. Применение ЭВМ для решения задач распознавания образов. Л. , 1983

11). Небабин В.Г. Распознавание формы сигналов // Зарубежная радиоэлектроника. 1981. №9. С.84-99.