- •Метод деления интервала пополам

- •5. Унимодальные функции. Метод «золотого сечения»

- •6. Метод Свенна для поиска отрезка, содержащего точку минимума

- •7. Одномерная оптимизация. Метод Ньютона-Рафсона

- •8. Одномерная оптимизация. Квазиньютоновский метод.

- •Случайный поиск

- •13. Метод Марквардта

- •14. Задачи с ограничениями. Поиск оптимума в задачах с ограничениями типа равенств. Метод неопределенных множителей Лагранжа.

- •16. Поиск оптимума в задачах с ограничениями. Метод факторов.

- •18. Линейное программирование. Преобразование основной задачи к основной задаче лп с ограничениями-неравенствами (форма а).

- •19. Линейное программирование. Геометрическое решение двумерных задач. Основная теорема о решении задачи лп.

13. Метод Марквардта

Этот

метод является комбинацией методов

градиентного спуска и Ньютона, в котором

удачно сочетаются положительные свойства

обоих методов. Движение в направлении

антиградиента из точки ![]() ,

расположенной на значительном расстоянии

от точки минимума

,

расположенной на значительном расстоянии

от точки минимума ![]() ,

обычно приводит к существенному

уменьшению целевой функции. С другой

стороны, направление эффективного

поиска в окрестности точки минимума

определяются по методу Ньютона.

,

обычно приводит к существенному

уменьшению целевой функции. С другой

стороны, направление эффективного

поиска в окрестности точки минимума

определяются по методу Ньютона.

Отметим,

что в различных модификациях метода

Ньютона требуется большое количество

вычислений, так как на каждой итерации

следует сначала вычислить элементы

матрицы

![]() ,

а затем решать систему линейных уравнений.

Применение конечно разностной

аппроксимации первых и вторых производных

только ухудшит ситуацию.

,

а затем решать систему линейных уравнений.

Применение конечно разностной

аппроксимации первых и вторых производных

только ухудшит ситуацию.

Поэтому в последнее время построено много, так называемых квазиньютоновских методов, как с аналитическим вычислением градиента и матрицы Гессе, так и с их конечно разностной аппроксимацией. Эти методы опираются на возможность аппроксимации кривизны нелинейной целевой функции без явного формирования ее матрицы Гессе. Данные о кривизне накапливаются на основе наблюдения за изменением градиента во время спуска.

Различные формы таких методов, часто называемые методами секущих, показали неплохие результаты в научных и технических исследованиях.

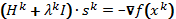

В

соответствии с методом Марквардта,

направление поиска ![]() определяется равенством

определяется равенством

![]() (1),

а новая точка

(1),

а новая точка ![]() задается формулой

задается формулой ![]() .

.

В

системе (1) I

– единичная матрица, ![]() –

матрица Гессе,

–

матрица Гессе, ![]() .

.

В

последней формуле коэффициент перед

![]() взят равным 1, так как параметр

взят равным 1, так как параметр ![]() в (1) позволяет менять и длину шага, и его

направление.

в (1) позволяет менять и длину шага, и его

направление.

На

начальной стадии поиска параметру ![]() приписывается некоторое большое

значение, например 104

,

так что

приписывается некоторое большое

значение, например 104

,

так что ![]()

Таким

образом, большим значением ![]() соответствует направление поиска

соответствует направление поиска

![]()

то есть направление наискорейшего спуска.

Из

формулы (1) можно заключить, что при

уменьшении λ

до нуля вектор ![]() изменяется от направления, противоположного

градиенту, до направления, определяемому

по Ньютону. Если после первого шага

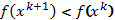

получена точка с меньшим значением

целевой функции, то есть

изменяется от направления, противоположного

градиенту, до направления, определяемому

по Ньютону. Если после первого шага

получена точка с меньшим значением

целевой функции, то есть ![]() , следует выбрать

, следует выбрать ![]() и реализовать еще один шаг. В противном

случае нужно положить

и реализовать еще один шаг. В противном

случае нужно положить ![]() ,

где

,

где ![]() ,

и вновь реализовать предыдущий шаг.

,

и вновь реализовать предыдущий шаг.

Заметим,

что недостатком метода Ньютона является

то, что если матрица Гессе ![]() не является положительно определенной,

то Ньютоновский шаг

не является положительно определенной,

то Ньютоновский шаг ![]() не приводит к убыванию функции. Поэтому

“исправление” Гессиана в соответствии

с формулой

не приводит к убыванию функции. Поэтому

“исправление” Гессиана в соответствии

с формулой ![]() модифицирует матрицу и при соответствующем

выборе

модифицирует матрицу и при соответствующем

выборе ![]() делает ее положительно определенной,

так как единичная матрица положительно

определена.

делает ее положительно определенной,

так как единичная матрица положительно

определена.

Приведем теперь алгоритм метода:

-

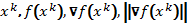

Задать

– начальное приближение к

– начальное приближение к  ,

M-максимально

допустимое количество итераций и

,

M-максимально

допустимое количество итераций и

– параметр сходимости.

– параметр сходимости. -

Положить

.

. -

Вычислить

.

.

-

Проверить ||

||.

Можно взять ||

||.

Можно взять || ||

=

||

=  .

Если да, то перейти к п.11.

.

Если да, то перейти к п.11. -

Проверить

?

Если да, то перейти к п.11.

?

Если да, то перейти к п.11. -

Вычислить шаг

,

решив систему

,

решив систему  .

. -

Положить

.

. -

Проверить:

.

Если да, то перейти к п.9, иначе к п.10.

.

Если да, то перейти к п.9, иначе к п.10. -

Положить

,.

Перейти к п.3.

,.

Перейти к п.3. -

Положить

.

Перейти к п.6.

.

Перейти к п.6. -

Вывод результатов:

,

k

,

k