- •1 Обзор современных методов диагностики и лечения панкреатита

- •1.1 Заболевания поджелудочной железы. Описание, причины и классификация заболеваний поджелудочной железы.

- •1.2 Панкреатит

- •1.2.1 Этиология и симптомы панкреатита

- •Острый панкреатит

- •Хронический панкреатит

- •1.2.2 Острый панкреатит

- •1.2.3 Хронический панкреатит

- •1.2.5 Лечение панкреатита

- •1.3 Нейросетевое моделирование систем

- •1.3.1 Основные понятия нейросетевой модели

- •Обучение нейронных сетей

- •Метод Розенблатта

- •Метод Уидроу-Хоффа

- •2 Анализ признаков панкреатита и разработка модели диагностики

- •3.1 Создание программного обеспечения и разработанная структурная схема

- •3.2 Описание информационно-программного обеспечения и основных функциональных блоков

- •4 Организационно-экономическая часть

- •4.1 Оценка целесообразности разработки программного продукта

- •4.2 Выбор и обоснование базовой модели

- •4.3.1 Расчет стоимости основных материалов

- •4.3.3 Расчет текущих расходов и износа оборудования

- •4.3.6 Определение отчислений на социальные нужды

- •4.3.7 Расчет договорной и продажной цены пп

- •4.3.8 Расчет цены потребления

- •4.4.1 Коэффициент цены потребления

- •4.4.2 Техническая прогрессивность нового изделия

- •4.5.6 Расчет относительной экономии капитальных вложений

- •4.5.8 Расчет годового экономического потенциала разработки

- •4.6 Расчет финансово-экономических результатов

- •4.7 Организация продаж программного продукта

- •5.1 Безопасность производственной среды

- •5.1.1 Анализ опасных и вредных факторов

- •5.1.2 Меры защиты от опасных и вредных факторов

- •5.1.2.1 Параметры микроклимата

- •5.1.2.3 Производственное освещение

- •5.1.2.4 Электромагнитное излучение

- •5.1.2.5 Статическое электричество

- •5.1.3 Расчет площади световых проемов при боковом освещении рабочего места врача при работе на эвм

- •5.2 Экологичность проекта

- •5.2.1 Анализ возможных негативных воздействий на врача

- •5.2.2 Мероприятия по защите окружающей среды от действия компьютеров

- •5.3 Чрезвычайные ситуации

- •5.3.1 Оценка возможности возникновения чс и план действий по их ликвидации

- •5.3.2 Пожарная безопасность при работе с компьютером

-

Обучение нейронных сетей

Способность к обучению является фундаментальным свойством мозга. В контексте ИНС процесс обучения может рассматриваться как настройка архитектуры сети и весов связей для эффективного выполнения специальной задачи. Обычно нейронная сеть должна настроить веса связей по имеющейся обучающей выборке. Функционирование сети улучшается по мере итеративной настройки весовых коэффициентов. Свойство сети обучаться на примерах делает их более привлекательными по сравнению с системами, которые следуют определенной системе правил функционирования, сформулированной экспертами.

Для конструирования процесса обучения, прежде всего, необходимо иметь модель внешней среды, в которой функционирует нейронная сеть - знать доступную для сети информацию. Эта модель определяет парадигму обучения.

Существуют три парадигмы обучения: "с учителем", "без учителя" (самообучение) и смешанная. В первом случае нейронная сеть располагает правильными ответами (выходами сети) на каждый входной пример. Веса настраиваются так, чтобы сеть производила ответы как можно более близкие к известным правильным ответам. Усиленный вариант обучения с учителем предполагает, что известна только критическая оценка правильности выхода нейронной сети, но не сами правильные значения выхода. Обучение без учителя не требует знания правильных ответов на каждый пример обучающей выборки. В этом случае раскрывается внутренняя структура данных или корреляции между образцами в системе данных, что позволяет распределить образцы по категориям. При смешанном обучении часть весов определяется посредством обучения с учителем, в то время как остальная получается с помощью самообучения.

Теория обучения рассматривает три фундаментальных свойства, связанных с обучением по примерам: емкость, сложность образцов и вычислительная сложность. Известны 4 основных типа правил обучения: коррекция по ошибке, машина Больцмана, правило Хебба и обучение методом соревнования.

Правило коррекции по ошибке. При обучении с учителем для каждого входного примера задан желаемый выход d. Реальный выход сети y может не совпадать с желаемым. Принцип коррекции по ошибке при обучении состоит в использовании сигнала (d-y) для модификации весов, обеспечивающей постепенное уменьшение ошибки. Обучение имеет место только в случае, когда перцептрон ошибается. Известны различные модификации этого алгоритма обучения.

Обучение Больцмана. Представляет собой стохастическое правило обучения, которое следует из информационных теоретических и термодинамических принципов. Целью обучения Больцмана является такая настройка весовых коэффициентов, при которой состояния видимых нейронов удовлетворяют желаемому распределению вероятностей. Обучение Больцмана может рассматриваться как специальный случай коррекции по ошибке, в котором под ошибкой понимается расхождение корреляций состояний в двух режимах .

Правило Хебба. Самым старым обучающим правилом является постулат обучения Хебба. Хебб опирался на следующие нейрофизиологические наблюдения: если нейроны с обеих сторон синапса активизируются одновременно и регулярно, то сила синаптической связи возрастает. Важной особенностью этого правила является то, что изменение синаптического веса зависит только от активности нейронов, которые связаны данным синапсом. Это существенно упрощает цепи обучения в реализации VLSI.

Обучение методом соревнования. В отличие от обучения Хебба, в котором множество выходных нейронов могут возбуждаться одновременно, при соревновательном обучении выходные нейроны соревнуются между собой за активизацию. Это явление известно как правило "победитель берет все". Подобное обучение имеет место в биологических нейронных сетях. Обучение посредством соревнования позволяет кластеризовать входные данные: подобные примеры группируются сетью в соответствии с корреляциями и представляются одним элементом.

При обучении модифицируются только веса "победившего" нейрона. Эффект этого правила достигается за счет такого изменения сохраненного в сети образца (вектора весов связей победившего нейрона), при котором он становится чуть ближе ко входному примеру.

Любая нейронная сеть, прежде всего, должна быть обучена. Процесс обучения заключается в подстройке внутренних параметров нейросети под конкретную задачу.

При обучении «классической» многослойной нейросети на вход подаются данные или индикаторы, а выход нейросети сравнивается с эталонным значением (с так называемым «учителем»). Разность этих значений называется ошибкой нейронной сети, которая и минимизируется в процессе обучения. Таким образом, обычные нейронные сети выявляют закономерности между входными данными и прогнозируемой величиной. Если такие закономерности есть, то нейросеть их выделит, и прогноз будет успешным.

Технология обучения с учителем НС предполагает наличие двух однотипных множеств:

-

множество учебных примеров — используется для «настройки» НС;

-

множество контрольных примеров — используется для оценки качества работы НС.

Элементами этих двух множеств есть пары (X, YI), где

-

X — входной вектор для обучаемой НС;

-

YI — верный (желаемый) выходной вектор для X.

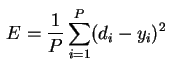

Так же необходимо определить функцию ошибки E. Обычно это средняя квадратичная ошибка (mean squared error — MSE)

,

,

где

-

P — количество обработанных НС примеров;

-

yi — реальный выход НС;

-

di — желаемый (идеальный) выход НС.

Процедура обучения НС сводится к процедуре коррекции весов связей HC. Целью процедуры коррекции весов есть минимизация функции ошибки E.

Общая схема обучения с учителем выглядит так:

1. Перед началом обучения весовые коэффициенты НС устанавливаются некоторым образом, на пример — случайно.

2. На первом этапе на вход НС в определенном порядке подаются учебные примеры. На каждой итерации вычисляется ошибка для учебного примера EL(ошибка обучения) и по определенному алгоритму производится коррекция весов НС. Целью процедуры коррекции весов есть минимизация ошибки EL.

3. На втором этапе обучения производится проверка правильности работы НС. На вход НС в определенном порядке подаются контрольные примеры. На каждой итерации вычисляется ошибка для контрольного примера EG (ошибка обобщения). Если результат неудовлетворительный то, производится модификация множества учебных примеров1 и повторение цикла обучения НС.

В случае однослойной сети алгоритм обучения с учителем прост. Желаемые выходные значения нейронов единственного слоя заведомо известны, и подстройка весов синаптических связей идет в направлении, минимизирующем ошибку на выходе сети.