- •1.3. Активаційні функції нейронів

- •4. Одношарові нейронні мережі

- •1.5. Персептрони і зародження штучних нейромереж

- •1.6. Багатошарові нейронні мережі

- •1.7. Навчання нейронних мереж

- •1.8. Алгоритм зворотного розповсюдження помилки (backpropagation)

- •2. Порядок виконання лабораторної роботи Завдання для варіантів V 1...V 100

- •Довідка для роботи з програмою „NeuroNet_Image_12”

- •Контрольні запитання та завдання

- •Список використаної літератури

Довідка для роботи з програмою „NeuroNet_Image_12”

Програма „NeuroNet_Image_12”, створена в середовищі Borland Delphi, призначена для навчання 3-шарової ШНМ методом зворотного розповсюдження помилки. На вхідний шар Х подаються зображення символів у вигляді одновимірних векторів (записується яскравість кожного пікселя зображення по рядках). На основі значень вектора Х розраховуються вектори прихованих шарів V1, V2 та вихідного шару Y. При навчанні мережі отримані виходи Y порівнюються з істинними YT, у випадку їх відмінності відбувається корекція матриць вагових коефіцієнтів W1, W2, W3. Процес навчання завершується, якщо отримана похибка mse (сумарна квадратична похибка εk) менша від заданої mse_Min.

Рис. 2.5. Головна форма програми „NeuroNet_Image_12”

Навчання ШНМ відбувається протягом часу Time_Delta. Для початку навчання потрібно натиснути кнопку „Навчити НМ”, завершити процес навчання можна кнопкою „Стоп”. Після успішного навчання матриці вагових коефіцієнтів W можна зберегти опцією „Зберегти_W”. Якщо ШНМ була навчена, то за допомогою опції „Розпізнати” можна виконати розпізнавання зображень символів. Значення вагових коефіцієнтів навчених ШНМ можна зчитати з файлу кнопкою „Відкрити_W”.

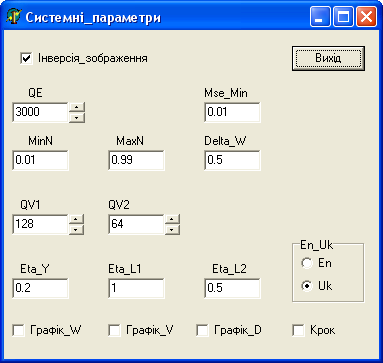

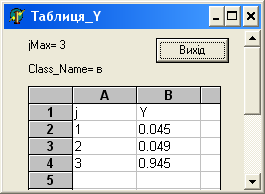

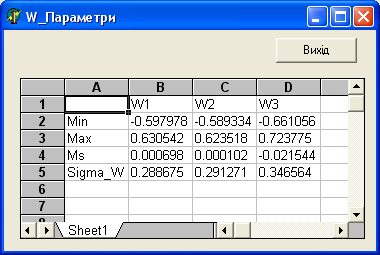

Опція „Сист_параметри” використовується для встановлення параметрів навчання (рис. 2.6). Опція „Результат_Y” показує результати навчання або розпізнавання (рис. 2.7). Опція „Показати_W_п” забезпечує перегляд параметрів вагових матриць (рис. 2.8).

Рис. 2.6. Параметри навчання ШНМ: QE – максимальна кількість епох навчання; MinN, MaxN – мінімальне й максимальне значення векторів ШНМ;

QV1, QV2 – кількість нейронів у прихованих шарах 1 та 2;

Eta_L1, Eta_L2, Eta_Y – норми навчання для відповідних шарів;

Mse_Min – допустима похибка навчання, Delta_W – початковий діапазон значень матриці W; прапорець „Інверсія_зображення” – встановити для чорних зображень на білому фоні; прапорці “Графік_W”, “Графік_V”, “Графік_D” – показати візуально матриці ваг W, вектори шарів V і вектори різниці D відповідно; прапорець „Крок” – виконувати навчання НМ по кроках

Рис. 2.7. Результати розпізнавання

Рис. 2.8. Параметри матриць вагових коефіцієнтів W

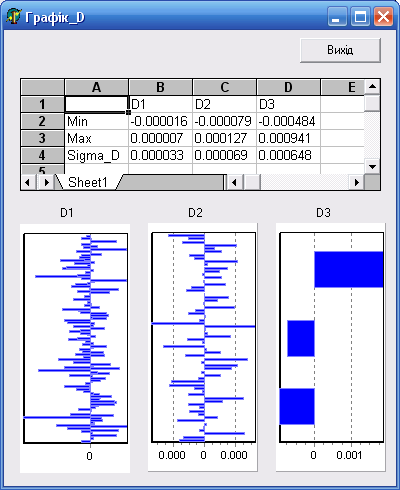

Рис. 2.9. Параметри векторів D

Опція „Показати_D” відображає вектори різниці D для всіх шарів (рис. 2.9).

Контрольні запитання та завдання

Що таке штучний нейрон?

Опишіть спрощену будову та принцип дії біологічного нейрона.

У чому полягає роль вагових коефіцієнтів?

Перерахуйте та опишіть основні активаційні функції нейронів, наведіть відповідні формули і графіки.

Чому як активаційна часто використовується сигмоїдна функція?

Зобразіть структуру одношарової нейромережі, поясніть принцип її функціонування.

Що таке „персептрон”?

У чому полягає головний недолік персептрона?

Зобразіть структуру багатошарової нейромережі, поясніть принцип її функціонування.

Чому для ефективної роботи багатошарової нейромережі активаційна функція повинна бути нелінійною?

Опишіть основні способи навчання нейромереж, поясніть їх недоліки та переваги.

У чому полягає концепція Хебба, яка використовується при навчанні НМ?

Опишіть алгоритм навчання нейромережі зі зворотним розповсюдженням помилки.

Яким чином формуються матриці вагових коефіцієнтів НМ?

Для чого потрібно проводити нормалізацію значень вхідних і вихідних векторів НМ?

Опишіть математичну модель прямого розповсюдження сигналу на прикладі 3-шарової нейромережі.

Як математично описуються помилки навчання нейромережі?

Опишіть математичну модель зворотного розповсюдження помилки на прикладі 3-шарової нейромережі.

Чому нейромережі ефективні при розпізнавані зображень?