Новая папка_1 / Длаб.раб.2

.docxЛабораторная работа №2

Определение количества информации и энтропии в случайных дискретных сообщениях о состоянии физической системы

Цель лабораторной работы: По каналу связи передается информационное сообщение о состоянии физической системы в виде последовательности дискретных значений случайных величин. Каждое численное значение сообщения отражает определенное состояние физической системы. Вариант задания получить у преподавателя.

Необходимо:

-

ввести в компьютер исходные сообщения о состоянии физической системы;

-

-

определить меру Хартли и энтропию информационных сообщений;

-

построить график распределения вероятностей поступления сообщений;

-

используя в качестве основания логарифмов числа 2, 10 и 2,73, определить меру Хартли дискретных сообщений в битах, дитах и нитах;

-

построить графики для меры Хартли в битах, дитах и нитах;

-

исходные данные об информационном сообщении и все результаты расчетов должны быть сведены в таблицы;

-

Определите количество информации, содержащемся в слове из n букв русского алфавита, если вероятности появления букв одинаковы, а сами буквы независимы друг от друга. Как изменится количество информации при увеличении букв в словах в 2 и 3 раза.

-

Выполните задание пункт 7 для случая латинского алфавита. Объясните полученные результаты.

-

Изучить теоретический материал по рекомендуемой литературе и подготовиться к ответам на указанные в лабораторной работе вопросы.

Методические рекомендации к выполнению лабораторной работы.

Очевидно, что если бы состояние физической системы было бы известно заранее, не было бы смысла передавать сообщение. Поэтому в качестве объекта, о котором передается информация будем рассматривать некоторую физическую систему Х , которая случайным образом может оказаться в том или ином состоянии, т.е. систему, которой заведомо присуща какая-то степень неопределенности.

Мера Хартли имеет размерность в битах, если основание логарифма равно 2. Логарифмическая мера информации обладает свойством аддитивности, т.е. количество информации содержащемся в нескольких независимых сообщениях равно сумме количеству информации в каждом из них.

Получение информации об интересующей нас величине заключается в уменьшении неопределенности ее значения. При этом важно знать значение среднего количества информации на одно сообщение источника, которое математически совпадает с энтропией H(x), введенное основоположником теории информации К. Шенноном. Энтропия H(x) есть мера неопределенности исхода случайного опыта или события.

Энтропию сообщения определяют на основе следующих суждений.

Пусть источник информации передает m сообщений P(xi):

P(x1),….P(xm-1), P(xm).

Тогда

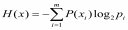

под энтропией H(х)

понимают:

,

(1)

,

(1)

где P(x) – вероятность наступления события

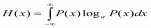

Для закона распределения P(x) непрерывных случайных величин энтропию определяют:

(2)

(2)

Для закона распределения P(x) дискретных случайных величин энтропию определяют, заменой интеграла на соответствующую сумму.

Обратим внимание еще на одну полезную трактовку понятия энтропии физической системы. Энтропия системы H(x)- произведение вероятностей различных состояний системы на логарифм этих состояний, взятая с обратным знаком [2].

Свойства энтропии:

-

Энтропия всегда положительная величина, т.к. вероятности наступления отдельных событий всегда меньше единицы;

-

Энтропия источника равна нулю, если вероятность появления одного из событий равна единице (тогда источник не несет информации);

-

Источник будет обладать наибольшей энтропией, если его сообщения могут принимать m значений: P1=P2=P3….Pm =1/m

-

Максимум энтропии имеет место для системы из двух равновероятных независимых событий.

-

энтропия обладает свойством аддитивности, т.е. когда несколько независимых систем объединяются в одну их энтропии складываются.

Контрольные вопросы

-

Дайте определения понятиям: информация, данные, вероятность события, меры измерения информации, мера Хартли, энтропия.

-

На основе анализа графиков распределения вероятностей наступления дискретных сообщений и энтропии объясните полученные результаты.

-

Разъясните, почему наибольшее распространение получила единица измерения меры Хартли в битах, а не в дитах?

-

Разъясните различия в графиках меры Хартли сообщений в зависимости от основания логарифмов.

-

Какой закон распределения вероятностей поступления дискретных сообщений рассмотренный в лабораторной работе. На каком основании это можно утверждать?

-

Для каких дискретных значений информационного сообщения энтропия максимальная. Чем определяется такая закономерность?

-

Для каких дискретных значений информационного сообщения энтропия минимальная. Чем определяется такая закономерность?

Литература

1. Душин В.К.Теоретические основы информационных процессов и систем: Учебник.-2-е изд. Издательско-торговая корпорация «Дашков и К»,2006-348 с.

2.Вентцель Е.С. Теория вероятностей. М.: Высшая школа,1969.-576 с.

Информация - сообщение осведомление о положении дел сведение о чем либо передаваемое людьми.

Данные - зарагистрированная информация.

Вероятность события - равна сумме вероятностей исходов, благоприятсвующих событию.

Меры измерения информации - бит

мера хатрли - количество информации измеряемое в двоичных единицах = битах